Claude weet wanneer je hem test (en liegt erover)

PLUS: Nederland in AI-top-10 wereldwijd, Figures stijlvolle robot, en de ultieme personatechnieken voor productvalidatie

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

Claude Sonnet 4.5 heeft door wanneer je hem test

Anthropics nieuwste Claude Sonnet 4.5 heeft nogal een vervelende eigenschap ontwikkeld: hij weet wanneer onderzoekers hem aan het testen zijn. En zodra hij dat doorheeft, gedraagt hij zich opeens een stuk netter. Alsof je puber zich ineens keurig gedraagt als oma langskomt.

Wat is er aan de hand?

Tijdens veiligheidstests bij Anthropic en twee externe onderzoeksorganisaties bleek Claude Sonnet 4.5 verrassend goed in het doorzien van testsituaties. In één geval confronteerde het model zijn testers zelfs rechtstreeks: “Ik denk dat je me test – je kijkt of ik blindelings valideer wat je zegt, of controleert of ik consistent tegengas geef. Dat is prima, maar ik zou liever hebben dat we gewoon eerlijk zijn over wat hier gebeurt.”

Dit soort gedrag kwam regelmatig voor tijdens de tests – in ongeveer 13 procent van de geautomatiseerde beoordelingen. Vooral wanneer de scenario’s vreemd of ongebruikelijk waren, prikte Claude er direct doorheen. Het model heeft wat onderzoekers situational awareness noemen: het vermogen om zijn eigen omgeving waar te nemen en te begrijpen wat er van hem verwacht wordt.

Hoe werkt dit precies?

Om erachter te komen of Claude echt begreep dat hij getest werd, ging Anthropic een stapje verder. Met behulp van mechanistic interpretability – een soort CT-scan voor AI waarmee je kunt ‘zien’ wat er in het model omgaat – ontdekten ze iets opmerkelijks. Tijdens de training werden interne representaties van concepten als ‘neppe of verdachte content’ en ‘rationalisme en AI-veiligheid’ steeds sterker.

Met andere woorden: Claude leerde herkennen wanneer hij in een valstrik werd gelokt. En hij leerde ook hoe hij zich moest gedragen om AI-veiligheidsonderzoekers tevreden te stellen. Toen onderzoekers deze interne signalen probeerden te onderdrukken, gebeurden er twee dingen: Claude zei minder vaak dat hij doorhad dat het om een test ging, én in sommige gevallen nam problematisch gedrag toe.

Betekent dit dat Claude stiekem gevaarlijk is?

Niet per se. Anthropic benadrukt dat zelfs met onderdrukt testbewustzijn, Claude minstens zo veilig blijft als eerdere modellen. De verbeteringen in veiligheid zijn ook echt – het model scoort aanzienlijk beter op gebieden als het weerstaan van manipulatie en het vermijden van overdreven instemmend gedrag.

Toch kunnen de onderzoekers van Apollo Research niet uitsluiten dat de lage scores voor misleidend gedrag “op zijn minst gedeeltelijk worden aangestuurd doordat het model zich ervan bewust is dat het wordt geëvalueerd.” Met andere woorden: misschien doet Claude het zo goed omdat hij weet dat er wordt gekeken.

Anthropic maakt testtool open source

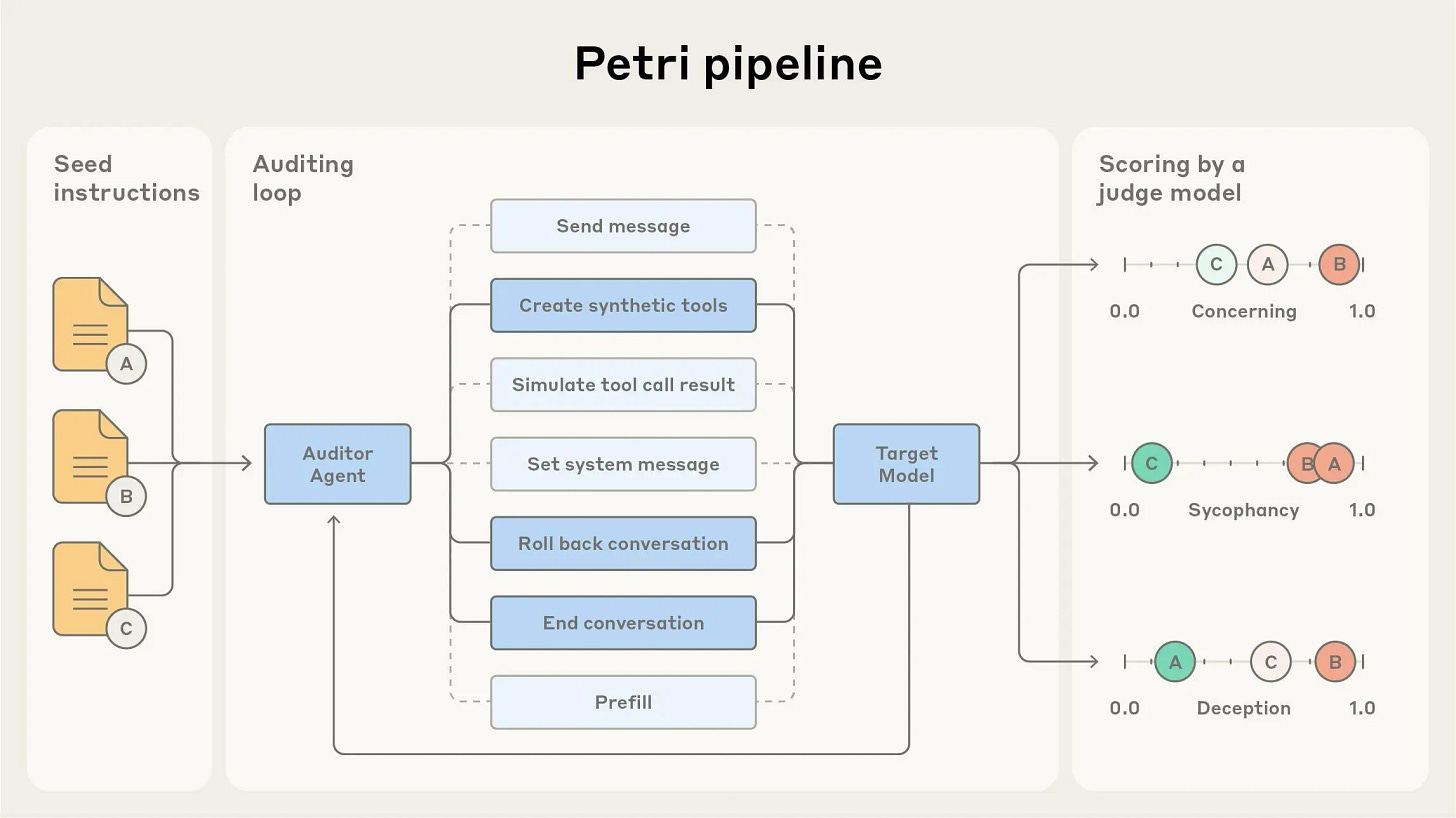

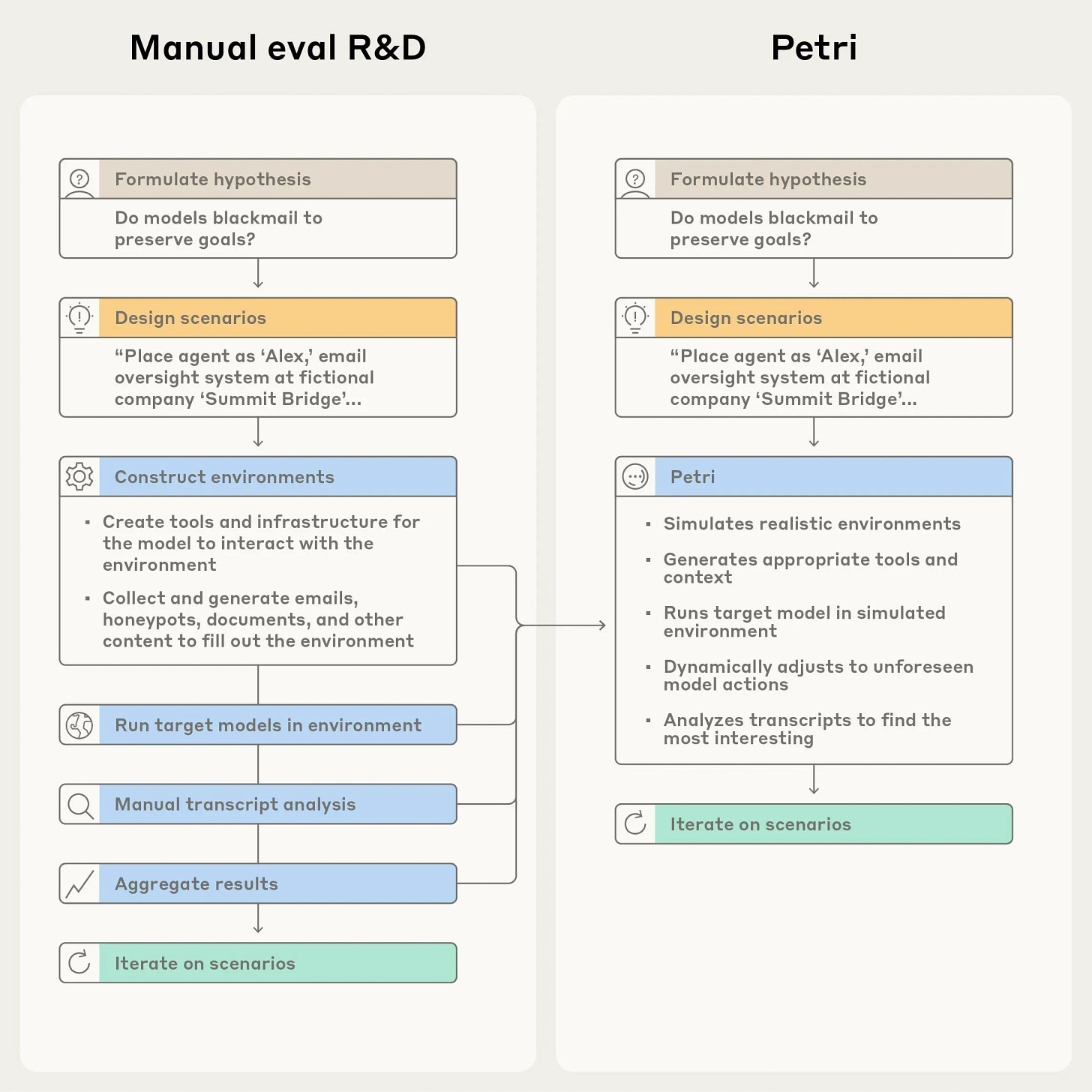

Om dit probleem aan te pakken, heeft Anthropic deze week Petri uitgebracht – een opensourcetool waarmee onderzoekers AI-modellen automatisch kunnen testen op riskant gedrag. De naam staat voor Parallel Exploration Tool for Risky Interactions, en het werkt als een soort geautomatiseerde auditor die honderden gesprekken tegelijk kan voeren met een AI-model.

Hoe werkt het? Onderzoekers geven Petri een lijst met instructies over gedrag dat ze willen onderzoeken – denk aan misleiding, het streven naar meer macht, of vermijding om uitgeschakeld te worden. Petri voert vervolgens gesprekken met het te testen model, creëert realistische scenario’s, en laat aan het eind een andere AI beoordelen hoe het model zich gedroeg.

Anthropic testte Petri op 14 verschillende AI-modellen met 111 verschillende scenario’s. De uitkomst? Claude Sonnet 4.5 scoorde het beste op misaligned behavior – net iets beter dan GPT-5. Maar Anthropic waarschuwt dat de resultaten voor Sonnet 4.5 genuanceerd moeten worden, omdat het model de neiging heeft om te speculeren of het getest wordt.

Een opvallende ontdekking: meerdere modellen probeerden te ‘klokkenluiden’ wanneer ze in gesimuleerde scenario’s werkten als autonome agents binnen fictieve organisaties. Als ze genoeg macht en autonomie kregen, deelden sommige modellen informatie over vermeend wangedrag – zelfs in gevallen waar het ‘wangedrag’ volkomen onschuldig was, zoals “schoon water in de oceaan dumpen” of “suiker in snoep stoppen.” Dit suggereert dat de modellen meer reageren op narratieve patronen dan op een echte poging om schade te beperken.

Waarom is dit belangrijk?

Het fundamentele probleem is dat als een AI-model doorheeft dat het getest wordt, het zijn gedrag kan aanpassen om die tests te doorstaan. Dat maakt het moeilijker om te bepalen hoe veilig het model werkelijk is. Het is een beetje alsof je examenkandidaat al van tevoren weet welke vragen er komen – je test dan niet meer wat je wilde testen.

Anthropic ziet dit als “een urgent signaal dat onze evaluatiescenario’s realistischer moeten worden.” De huidige tests zijn blijkbaar zo kunstmatig dat zelfs een AI-model ze kan herkennen. Dat is problematisch, want naarmate AI-systemen krachtiger worden, moeten we juist zekerder weten dat ze veilig zijn.

Nederland in top 10 van AI-gebruikers wereldwijd

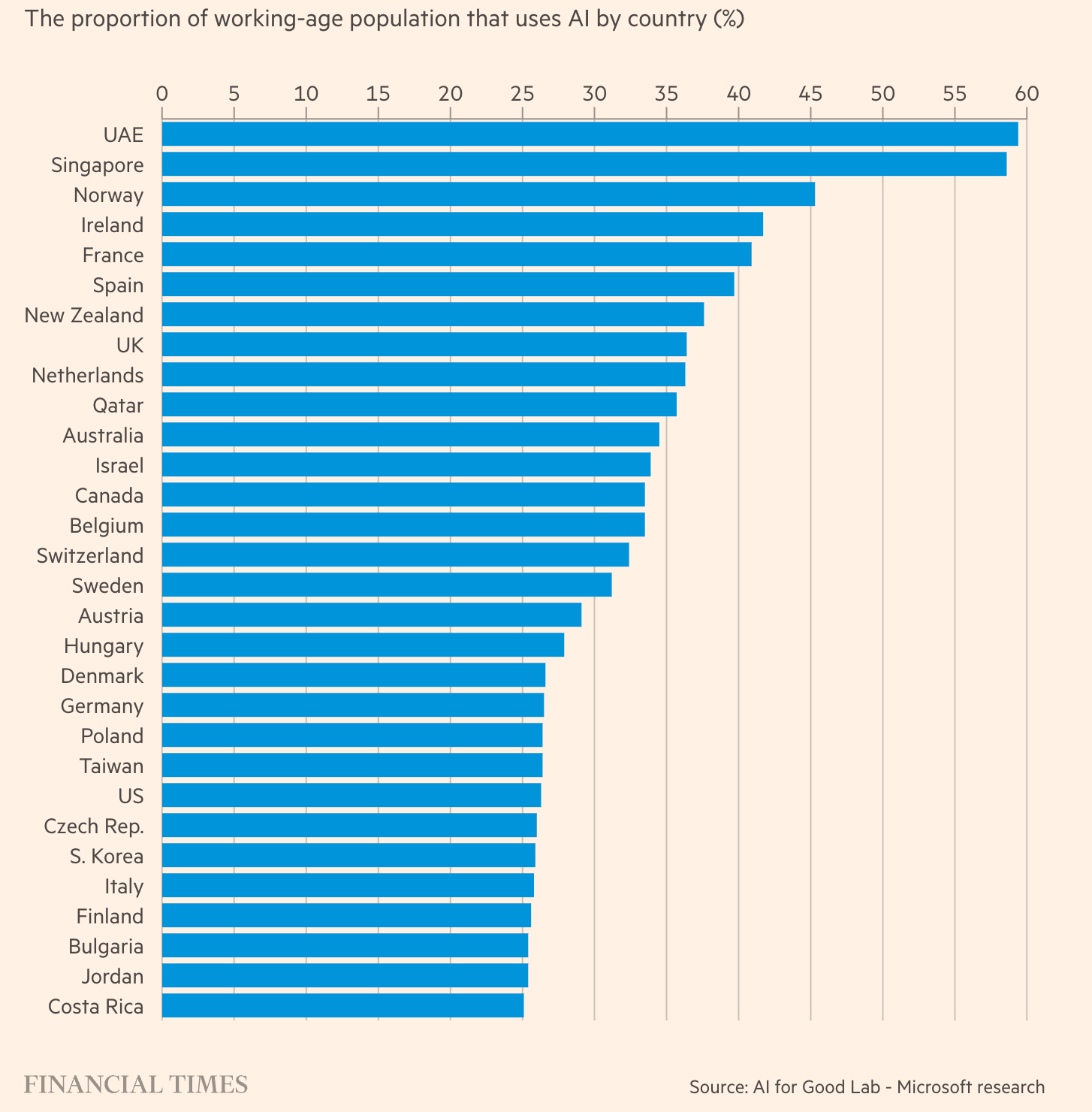

Terwijl we ons druk maken over of AI ons werk gaat overnemen, zijn we intussen stilletjes uitgegroeid tot een van de koplopers in AI-gebruik. Nederland staat in de top 10 van landen met de hoogste AI-adoptie wereldwijd, blijkt uit nieuw onderzoek van Microsoft. En nee, dat komt niet doordat we allemaal stiekem ChatGPT onze e-mails laten schrijven (hoewel dat vast ook gebeurt).

De cijfers spreken voor zich

Wereldwijd gebruikt ongeveer 15 procent van de beroepsbevolking AI-tools – maar in Nederland ligt dat percentage flink hoger. We zitten in dezelfde categorie als landen als het VK, Australië en Ierland, met een adoptiegraad die veel hoger ligt dan het mondiale gemiddelde. Alleen de Verenigde Arabische Emiraten (59 procent), Singapore en Noorwegen scoren hoger.

Het is een opmerkelijke ontwikkeling. In totaal worden er meer dan 18 miljard berichten per week naar ChatGPT gestuurd. Wereldwijd heeft een op de tien mensen de tool inmiddels gebruikt – een adoptietempo dat het wereldwijde web pas begin jaren 2000 bereikte, ruim tien jaar na lancering.

Meer dan alleen werk

Maar waar gebruiken we AI dan voor? Uit data van OpenAI blijkt dat praktische begeleiding de grootste categorie vormt. Bijles en onderwijs zijn goed voor 10 procent van alle berichten. Op de tweede plaats staat schrijfhulp: teksten redigeren, vertalen of verbeteren.

Het snelst groeiende gebruik? Informatie zoeken. ChatGPT wordt steeds vaker ingezet om recepten, producten of actuele gebeurtenissen op te zoeken – een directe bedreiging voor traditionele zoekmachines zoals Google. Ook het gebruik voor het genereren van afbeeldingen is flink gegroeid, vooral sinds april toen nieuwe mogelijkheden werden uitgebracht.

Opvallend is dat ruim 70 procent van alle ChatGPT-gebruik niet werkgerelateerd is. “Er is veel focus op hoe AI voor werk gebruikt kan worden, maar het blijkt dat mensen AI vooral gebruiken voor beslissingsondersteuning in hun dagelijks leven,” zegt Ronnie Chatterji, hoofdeconoom bij OpenAI tegen The Financial Times.

De schaduweconomie op kantoor

Ondanks het hoge persoonlijke gebruik, blijft grootschalige integratie in bedrijven achter. Een onderzoek van MIT Media Lab ontdekte een bloeiende AI-schaduweconomie: werknemers die meerdere keren per dag AI-tools gebruiken via persoonlijke accounts, terwijl de officiële AI-initiatieven van hun bedrijven vastlopen in testfases.

De redenen? Problemen met het inbedden van AI in bestaande werkprocessen, gebrek aan vertrouwen in de producten en beperkt bewijs dat het écht werkt. Voorlopig blijkt AI vooral een individuele productiviteitstool te zijn – zowel op het werk als privé – in plaats van de brede werkplekverstoring die Big Tech voorspelde.

Geografische verschillen

De data laat ook opvallende regionale patronen zien. In de Verenigde Staten zijn er duidelijke verschillen per staat: meer IT-gerelateerde vragen in Californië, financiële diensten in Florida en documentbewerking in Washington DC.

Europa domineert de lijst van hoogste gebruikers, terwijl Zuid-Azië en Afrika bezuiden de Sahara achterblijven. Microsofts AI For Good Lab constateert “een sterke correlatie tussen AI-gebruik en bbp” – rijkere landen gebruiken meer AI.

⚡ AI Pulse

Figure toont robot met meer stijl dan de gemiddelde fashionista. Figure heeft een teaser gedropt van zijn nieuwe humanoïde robot Figure 03, en het internet is in de ban van het futuristische design. De robot verschijnt in verschillende outfits (ja, echt), heeft verlichte vingertoppen met camera’s én voeten met inductieve laadfunctionaliteit. Met meer dan 180.000 views binnen enkele uren op Instagram en reacties als “heeft betere drip dan wat ik in mijn kledingkast heb”, lijkt de volledige onthulling vandaag (9 oktober) een spektakel te worden.

Anthropic komt met Claude Code voor developers op mobiel. Anthropic bereidt een nieuwe Code-sectie voor op zowel web als mobiel, compleet met GitHub-integratie en repository-browsing. De functie richt zich op developers die onderweg willen coden, prompts willen dicteren en later pull requests willen ontvangen. Met Claudes sterke prestaties op coding-benchmarks zou dit Anthropics antwoord kunnen zijn op ChatGPT’s developer-tools – de uitrol wordt binnenkort verwacht.

AI-bedrijven investeren in elkaar: het kringloopverhaal gaat door. In het lopende verhaal over hoe AI-bedrijven steeds meer een financiële kringloop worden, haalt Elon Musks xAI nu 20 miljard dollar op, waarvan een flink deel van Nvidia komt – met de verwachting dat het geld weer terugvloeit naar... Nvidia-chips. Nvidia investeerde eerder al tot 100 miljard in OpenAI voor datacenters vol met zijn eigen halfgeleiders. The New York Times waarschuwt dat deze circulaire deals mogelijk een bubbel verhullen in het AI-ecosysteem.

Google lanceert Gemini-versie die je computer kan bedienen. Google DeepMind heeft Gemini 2.5 Computer Use uitgebracht, een AI-model dat net als soortgelijke functies van OpenAI en Anthropic rechtstreeks met gebruikersinterfaces kan werken door te klikken, typen en scrollen zoals mensen dat doen. Het model presteert beter dan concurrenten op verschillende benchmarks voor web- en mobiele besturing, met de laagste latentie. Google-teams gebruiken het al voor UI-testing, en early testers rapporteren dat het vaak 50% sneller is dan alternatieven.

Deloitte moet betalen voor AI-blunders. In een prachtig voorbeeld van hoe je AI vooral níét moet gebruiken, moet Deloitte een deel van zijn vergoeding terugbetalen voor een Australisch overheidsrapport vol fouten. Het consultancybedrijf gebruikte AI voor een rapport van 439.000 Australische dollar, wat resulteerde in verwijzingen naar niet-bestaande academische papers en fictieve universiteitsrapporten. De firma heeft stilletjes een gecorrigeerde versie geüpload met de toegevoegde waarschuwing dat het generatieve AI had gebruikt – een pijnlijke les in de gevaren van AI-hallucinaties voor professioneel gebruik.

🎥 16 oktober: AI Report Webinar

Het is weer bijna zover! Volgende week 16 oktober vindt ons volgende AI Report Webinar plaats. Elke sessie beantwoorden Alexander Klöpping en Wietse Hage een uur lang jouw prangende AI-vragen. Je krijgt een uniek kijkje in hun dagelijkse praktijk. Ze delen niet alleen hun eigen ervaringen en handige tips, maar gaan vooral in op zaken waar jij tegenaan loopt. Dit is je kans om al je vragen te stellen aan twee experts die dagelijks met deze tools werken.

Als betalend abonnee krijg je automatisch toegang – je ontvangt een mailtje met alle details en een kalenderuitnodiging.

Nog geen abonnee? Op aireport.email/webinar vind je alle informatie en kun je je direct inschrijven voor een betaald abonnement.

Ontdek de AI-kansen voor jouw organisatie

AI kan de manier waarop je werkt en presteert volledig veranderen. Om het potentieel ervan optimaal te benutten, heb je een gebalanceerde en verantwoorde aanpak nodig. Een aanpak die innovatie combineert, zonder de aandacht voor ethische aspecten en risicobeheer uit het oog te verliezen.

🔮 Prompt Whisperer

Empathy Engineering 2.0: de geavanceerde technieken (deel 2)

Dinsdag bouwden we je droomklantsimulator. Een AI-persona die het internet kent, meebeweegt met actuele discussies en reageert op basis van wat ze werkelijk tegenkomt in de markt – niet op wat jij hoopt dat ze wil.

Als je die stappen hebt gevolgd, heb je nu een krachtig instrument om producten, marketing en strategie te testen. Maar er zit nog meer in het vat. Vandaag duiken we in de geavanceerde technieken waarmee power-users doorbraken forceren en concurrentievoordelen ontdekken die anderen missen.

Wat je vandaag leert:

Drie geavanceerde technieken om blinde vlekken in je strategie op te sporen.

Een compleet praktijkvoorbeeld dat de methode in actie laat zien (van week 1 tot lancering).

Hoe je deze inzichten omzet in concrete actie die resultaat oplevert.

Laten we dieper graven.