De robot die zichzelf leert origami te vouwen

PLUS: wees bij onze allereerste webinar vandaag, draai met Googles nieuwe model krachtige AI op je eigen laptop, en een techniek die AI-hallucinaties drastisch vermindert

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

💡 Vandaag: allereerste AI Report-webinar!

Over een halfuur gaan we live met Alexander en Wietse! Ze beantwoorden een uur lang al je AI-vragen en delen hun dagelijkse ervaringen, direct vanuit de Amsterdamse studio.

Als betalend abonnee krijg je automatisch toegang – onderaan deze mail vind je de link naar de meeting. Nog geen lid? Voor een tientje per maand ben je verzekerd van je plek bij alle webinars én ontvang je tweewekelijks onze volledige nieuwsbrief.

Tot zo!

🗞️ Het belangrijkste nieuws

Gemini Robotics: Google lanceert zelflerende robots

In de race naar de eerste thuisrobot die je sokken sorteert, geeft Google een stevige duw tegen de deur van de toekomst. Het bedrijf lanceerde deze week Gemini Robotics: nieuwe AI-modellen die robots in staat stellen taken uit te voeren die ze nooit eerder hebben gezien – zonder specifieke training vooraf. Ja, zelfs dingen die wij na drie YouTube-tutorials nog steeds niet voor elkaar krijgen.

Wat is dit?

Gemini Robotics bestaat uit twee AI-modellen die voortbouwen op Gemini 2.0, de nieuwste generatie van Googles grote taalmodel. Het eerste model, simpelweg Gemini Robotics genoemd, stuurt de robots direct aan. Het tweede, Gemini Robotics-ER (‘embodied reasoning’), geeft de robots ruimtelijk inzicht en redeneervermogen. Het bijzondere: deze modellen kunnen robots besturen die ze nog nooit eerder hebben gezien, ongeveer zoals jij direct zou weten hoe je een nieuwe afstandsbediening moet gebruiken.

In de demonstratievideo’s zie je robots die origami vouwen met een precisie waar de gemiddelde knutselaar jaloers op zou worden, en die met een basketbal een slam dunk maken alsof het niks is. De robots kunnen zelfs reageren als ze halverwege een taak worden onderbroken – iets wat de meeste programmeerbare robotarmen net zo goed kunnen als een kat die luistert naar commando’s.

‘Gemini 2.0 kan een robot besturen zonder ooit met robotdata te zijn getraind,’ staat er in de onderzoekspaper. ‘Het kan alle noodzakelijke stappen uitvoeren: waarnemen, omgevingsanalyse, ruimtelijk redeneren, plannen en aansturing – direct uit de doos.’

Context en betekenis

Dit doet denken aan de doorbraak van AlphaGo in 2016, toen DeepMind (nu onderdeel van Google) de wereldkampioen Go versloeg. Net zoals AlphaGo zelf leerde door reinforcement learning – steeds beter worden door ervaring – kunnen deze robots taken leren zonder specifieke programmering vooraf.

De echte vooruitgang is de verbinding tussen grote taalmodellen en robotica. Door Gemini’s wereldkennis – opgedaan uit miljarden internetbronnen – te koppelen aan fysieke besturing krijgen robots toegang tot een schat aan praktische kennis, zonder dat ontwikkelaars dit expliciet hoeven te programmeren. De robot begrijpt wat een koffiekopje is en hoe je het zou moeten oppakken, zelfs als het dat specifieke kopje nog nooit heeft gezien.

Reed Albergotti van Semafor legt de vinger op de zere plek: ‘Je bouwt de fysieke robot, Googles AI-modellen maken dat het werkt. Met andere woorden: we gokken niet langer op afzonderlijke oplossingen voor specifieke problemen, maar op één enkel AI-systeem dat alle problemen kan leren oplossen.’

Taalmodellen + robots = match made in…?

Google DeepMind-oprichter Demis Hassabis ziet een breder patroon: ‘Een echte universele digitale assistent moet niet alleen taal begrijpen, maar ook de ruimtelijke en tijdelijke context waarin je je bevindt.’ Hij vervolgt: ‘Voor robotica heb je precies dezelfde eigenschappen nodig. Ik denk dat uiteindelijk dergelijke modellen zullen worden gebruikt voor robotica en zelfs zelfrijdende auto’s. Waymo zal uiteindelijk zijn huidige technologie vervangen door één AI-model, waarschijnlijk een toekomstige versie van Gemini.’

Nature-journalist Elizabeth Gibney beschrijft de hoop die experts koesteren over de versmelting van taalmodellen en robotica: ‘De snelle vooruitgang in kunstmatige intelligentie zou eindelijk het gat kunnen dichten. Voor wetenschappers die opgroeiden met Star Wars is het teleurstellend dat er geen C-3PO-achtige droids door onze steden en huizen wandelen. Waar zijn de mensachtige robots met gezond verstand die kunnen helpen in huis en op de werkplek?’

Akshara Rai, AI-onderzoeker bij Meta, vertelt: ‘De laatste stap naar ware intelligentie moet fysieke intelligentie zijn.’ Deze overtuiging dat belichaming essentieel is voor echte AI, delen veel onderzoekers inmiddels.

Veiligheid voorop: Asimovs wetten in de praktijk

Opvallend is de manier waarop Google de nadruk legt op veiligheid, met een expliciet framework geïnspireerd op Isaac Asimovs beroemde Drie Wetten van de Robotica. Voor wie de sciencefictionklassieker gemist heeft: Asimov bedacht regels die in elke robot zouden moeten worden geprogrammeerd:

Een robot mag een mens geen kwaad doen of door niet te handelen toestaan dat een mens schade oploopt.

Een robot moet de bevelen van mensen opvolgen, tenzij dit in strijd is met de Eerste Wet.

Een robot moet zijn eigen bestaan beschermen, zolang dit niet in strijd is met de Eerste of Tweede Wet.

Google heeft deze fictieve regels vertaald naar een praktisch veiligheidsframework dat roboticaonderzoekers kunnen gebruiken om grenzen te stellen aan wat een robot mag doen. Ze noemen dit de ‘Robot Constitution’ – wat klinkt als een document dat over een paar decennia in het Rijksmuseum zou kunnen hangen.

Kanttekeningen

Ondanks alle beloften is er reden tot scepsis. De markt voor robotica is al overvol, met partijen als Boston Dynamics, Figure, Tesla en talloze start-ups die allemaal beweren de volgende revolutie te ontketenen. Googles Waymo heeft vijftien jaar nodig gehad om zijn zelfrijdende taxi’s eindelijk commercieel inzetbaar te maken – een teken dat de weg van demo naar dagelijks gebruik steiler is dan technologiebedrijven graag toegeven.

Sommige kritische stemmen wijzen op Googles historische problemen met het omzetten van uitstekende technologie in succesvolle producten. Het bedrijf mag dan cutting edge AI-modellen, hardwareversnelling en robotica in huis hebben, maar zoals een voormalig Google-medewerker opmerkte: ‘Google heeft een lange geschiedenis van niet in staat zijn om geweldige producten te bouwen op basis van geweldige technologie.’ De uitdaging is niet zozeer technisch als wel cultureel – kan Google snel genoeg itereren en focussen?

Waarom is dit belangrijk?

Googles samenwerking met Apptronik voor het bouwen van mensachtige robots en het beschikbaar stellen van Gemini Robotics-ER aan partners als Boston Dynamics en Agility Robots versnellen de ontwikkeling van praktische toepassingen aanzienlijk. Voor bedrijven betekent dit robots die flexibel kunnen reageren in onvoorspelbare omgevingen – cruciaal voor magazijnen en fabrieken waarin de omstandigheden constant veranderen.

De versmelting van taalmodellen en robotbesturing markeert een belangrijke verschuiving. Dezelfde AI die je chatgesprekken mogelijk maakt, zal straks ook fysieke apparaten besturen. Op termijn zal Googles ervaring met Waymo waarschijnlijk samenvloeien met deze robotica-initiatieven, wat leidt tot systemen die zowel kunnen navigeren als communiceren.

Voor consumenten is de belofte helder: binnen enkele jaren komen er slimmere huishoudrobots die meerdere taken kunnen uitvoeren zonder specifieke programmering per taak. Misschien is straks de grootste uitdaging niet de technologie, maar het overtuigen van je partner dat je écht een robotbutler nodig hebt.

Googles Gemma 3: AI-krachtpatser voor je laptop (én je telefoon)

Het is weer de ‘Week van Google’. Na de robotsensatie komt Google met een aankondiging die het AI-landschap flink opschudt. Gemma 3 is gearriveerd: een AI-model dat volgens Google werkt op één enkele GPU en daarmee zowat elk ander openbaar beschikbaar model verslaat. Een Ferrari-motor in je Fiat, zeg maar.

Wat is dit?

Gemma 3 is de nieuwste versie van Googles ‘open’ AI-model, gebouwd op dezelfde technologie als hun premium Gemini 2.0. Het komt in vier formaten (1B, 4B, 12B en 27B paramaters) en kan tekst, afbeeldingen én korte video’s verwerken. Het bijzondere: waar de krachtigste AI-modellen een datacenter nodig hebben, draait Gemma 3 op één enkele GPU – en de kleinste versie zelfs op je smartphone.

Google claimt dat het de ‘beste AI ter wereld is voor één accelerator’, en stelt dat het krachtiger is dan concurrenten als Llama, DeepSeek en OpenAI’s o3-mini wanneer het draait op één NVIDIA-GPU. Het context window, het ‘werkgeheugen’ van de AI, is ook flink opgevoerd naar 128.000 tokens – genoeg voor ongeveer 300 pagina’s tekst.

Context en betekenis

In een tijd waarin AI-modellen maar blijven groeien (denk aan 1 biljoen+ parameters), kiest Google een opvallend andere koers: efficiëntie. Ze maken AI die ook werkt zonder toegang tot een datacenter.

Deze beweging komt niet uit het niets. De populariteit van modellen als DeepSeek R1, die lokaal kunnen draaien op een krachtige thuiscomputer, laat zien dat er veel vraag is naar AI die niet afhankelijk is van clouddiensten. Een tweet die viral ging, toonde onlangs iemand die het volledige DeepSeek R1 draaide op twee Mac Studio’s – een prestatie die computerliefhebbers deed watertanden.

Gemma 3 gaat nog een stap verder door optimalisaties voor verschillende soorten hardware – van high-end GPU’s tot smartphones – en ondersteuning voor meer dan 35 talen (en pre-training voor 140+ talen).

De vibe check

Aaron Levie, CEO van Box, schetst de snelheid van de ontwikkelingen: ‘Bizar dat nieuwe modellen vandaag beter presteren dan toonaangevende modellen die slechts een jaar geleden 15 keer zo groot waren.’

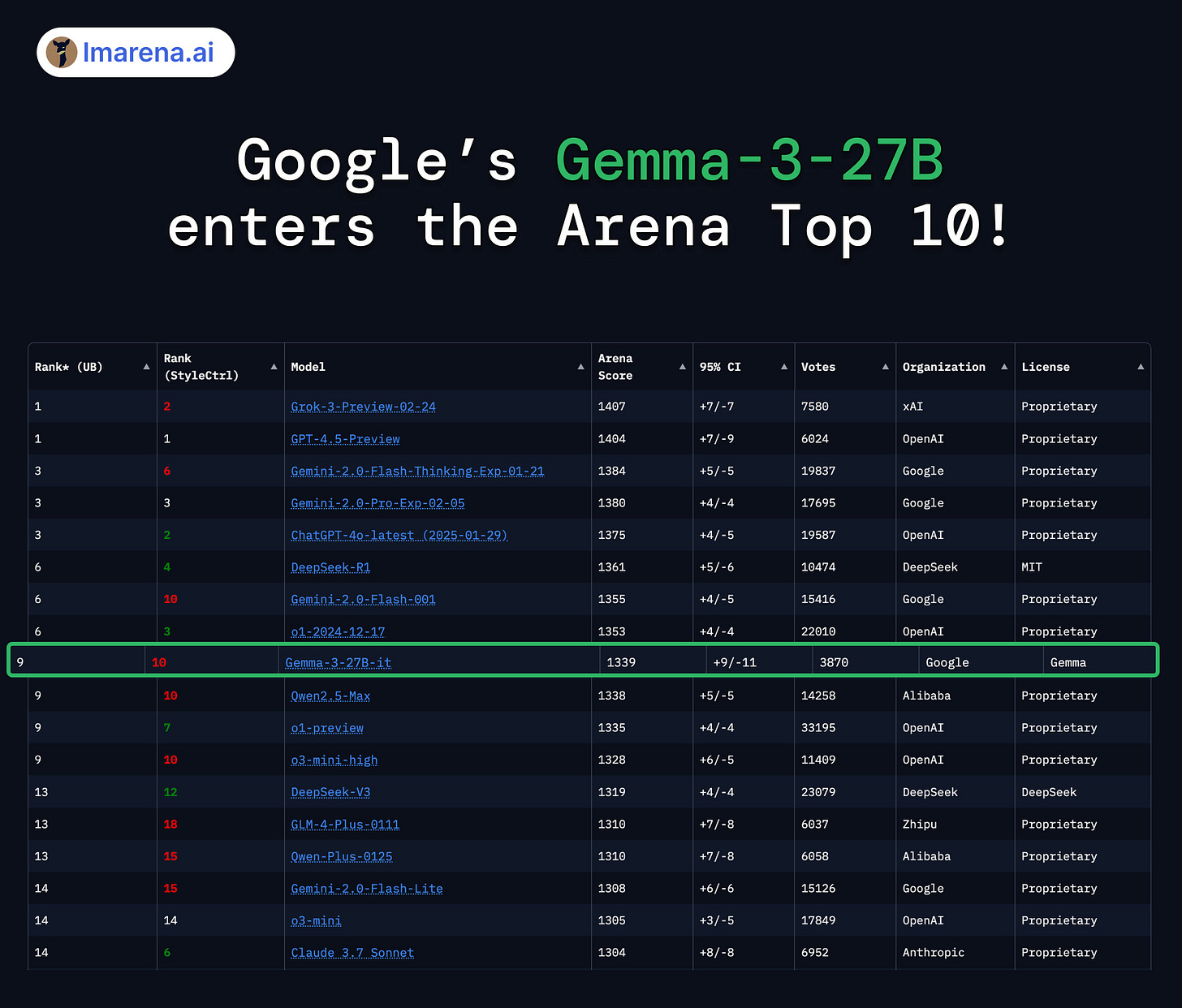

De populaire AI-benchmarksite LMArena is ronduit enthousiast: ‘Gefeliciteerd, Google DeepMind, met Gemma-3-27B, een van de sterkste open modellen in Arena! Top 10 overall – verslaat vele frontier-modellen met slechts 27B parameters. Op een na beste open model, alleen onder DeepSeek R1.’ Hun test bevestigt Googles claims en onderstreept hoe uitzonderlijk het is dat een relatief klein model zoveel grotere concurrenten achter zich laat.

In de LocalLLaMa-community, waar enthousiastelingen AI-modellen lokaal draaien, zijn de reacties ook enthousiast. Een tester meldt: ‘Het is het beste visiemodel dat ik heb geprobeerd van deze grootte. Ik wil alleen maar een kleine LLM om thuis mee te werken met multimodale capaciteiten.’

Kanttekeningen

Net als bij Gemini Robotics is het de vraag of Google dit prachtige stukje technologie kan omzetten in een succesvolle productlijn. Gemma 2 was al indrukwekkend, maar heeft nooit dezelfde bekendheid gekregen als bijvoorbeeld ChatGPT of Claude.

Verder zijn de veiligheidsclaims interessant geformuleerd. Google schrijft: ‘Gemma 3’s verbeterde STEM-prestaties hebben geleid tot specifieke evaluaties gericht op mogelijk misbruik bij het maken van schadelijke stoffen; de resultaten wijzen op een laag risiconiveau.’ Een ietwat omslachtige manier om te zeggen dat ze hebben gecheckt of je er bommen mee kunt bouwen.

Waarom is dit belangrijk?

De release van Gemma 3 markeert een belangrijke transitie in de AI-wereld. Terwijl OpenAI en Anthropic inzetten op steeds grotere modellen die alleen in datacenters draaien, maakt Google kunstmatige intelligentie beschikbaar voor lokaal gebruik op persoonlijke apparaten.

Voor ontwikkelaars betekent dit toegang tot krachtige AI zonder torenhoge cloudkosten. Voor eindgebruikers komt er een toekomst aan waarin je privacygevoelige AI-taken lokaal kunt uitvoeren zonder je gegevens naar externe servers te sturen. Voor hobbyisten is het een kans om te experimenteren met AI zonder afhankelijk te zijn van betaalde API’s.

Met meer dan 100 miljoen downloads van eerdere Gemma-modellen en 60.000 gefinetunede varianten in wat Google de ‘Gemmaverse’ noemt, is duidelijk dat lokale AI-modellen geen niche meer zijn – ze zijn de volgende stap.

🔮 Prompt whisperer

Chain-of-Verification: een leugendetector voor je AI

Zo verminder je hallucinaties en vergroot je de betrouwbaarheid

Wie kent het niet: je vraagt ChatGPT iets over ‘politici geboren in New York’ en voor je het weet beweert het dat Hillary Clinton daarvandaan komt (terwijl dat Chicago is). Je AI-assistent klinkt zó zelfverzekerd dat je het bijna zou geloven – totdat je het controleert.

Dit fenomeen heeft een naam: hallucinatie. Het is als een vriend die tijdens een borrel met veel bravoure onzin verkondigt. Vervelend, maar erger nog: het ondermijnt je vertrouwen in alles wat hij je vertelt. Zoals Snowflake-CEO Sridhar Ramaswamy het treffend verwoordt: ‘Het verraderlijke aan hallucinaties is niet dat het model 5 procent van de antwoorden verkeerd heeft, maar dat je niet weet wélke 5 procent verkeerd is – en dat is een vertrouwenskwestie.’

Moderne taalmodellen kunnen volgens onafhankelijke schattingen tussen de 1 en bijna 30 procent van de tijd hallucineren. Het probleem? Techbedrijven zijn niet transparant over deze cijfers. ‘Als je goed kijkt, publiceert niemand de hallucinatiepercentages van zijn modellen of oplossingen,’ zegt Ramaswamy. ‘Het is meer van: “Kijk hoe gaaf we zijn, je moet ons gewoon gebruiken.”’

Toch zijn hallucinaties niet alleen maar negatief. OpenAI-CEO Sam Altman verdedigt ze zelfs: ‘Als je simpelweg zegt: “Zeg nooit iets waarvan je niet 100 procent zeker bent”, dan kun je dat voor elkaar krijgen. Maar dan verlies je de magie die mensen zo waarderen.’ Anthropic-medeoprichter Jared Kaplan voegt daaraan toe: ‘Als je AI traint om nooit te hallucineren, wordt ze heel, heel voorzichtig met het maken van fouten en zal ze bij alles zeggen: “Ik ken de context niet.”’

Gelukkig is er een middenweg: Chain-of-Verification (CoVe), een krachtige promptingstrategie die door onderzoekers van Meta is ontwikkeld. Het vermindert hallucinaties drastisch zonder de creativiteit van AI-modellen te beperken.