Bouw je eigen appjes op de bank... vanaf je telefoon

PLUS: de volledige 'opvoeding' van Claude onthuld, wetenschappers waarschuwen voor AI-zwermen, en EU onderzoekt Grok om deepfakes

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

Anthropic publiceert de ‘opvoedingshandleiding’ van Claude

Vorige maand lekte het per ongeluk, nu is het officieel: Anthropic heeft de complete grondwet van Claude openbaar gemaakt. Een document van ruim 10.000 woorden dat beschrijft hoe de AI moet denken, handelen en – opvallend genoeg – hoe het zichzelf mag zien.

Wat is dit precies?

Anthropic, het bedrijf achter de populaire AI-assistent Claude, noemt het document een ‘grondwet’. Maar het is eerder een kruising tussen een opvoedingshandleiding en een persoonlijkheidsomschrijving. Het document legt niet alleen vast wat Claude wel en niet mag doen, maar vooral waarom.

Die aanpak is nieuw. Waar eerdere versies bestonden uit een waslijst losse regels, kiest Anthropic nu voor uitleg en context. De gedachte: als je wilt dat een AI goed oordeelt in situaties die niemand heeft voorzien, moet het begrijpen waarom bepaalde waarden belangrijk zijn – niet alleen welke regels het moet volgen.

Van regels naar karakter

Amanda Askell, de filosoof die Claudes persoonlijkheid vormgeeft, legde in een interview uit waarom deze verschuiving nodig was. Een strakke regellijst kan averechts werken: een AI die blind regels volgt, kan precies het verkeerde doen in situaties waar de regel niet op slaat.

Neem een instructie als ‘verwijs gebruikers altijd door naar professionele hulp bij emotionele onderwerpen’. Klinkt veilig, maar een AI die dit mechanisch toepast, wordt eerder irritant dan behulpzaam. De nieuwe aanpak: geef Claude de onderliggende waarden mee (zorg voor welzijn, respect voor autonomie) en vertrouw erop dat het zelf kan inschatten wanneer doorverwijzen gepast is.

De hiërarchie: veiligheid boven alles

Het document stelt vier prioriteiten vast, in deze volgorde: veiligheid eerst, dan ethisch handelen, dan Anthropics richtlijnen volgen, en als laatste: oprecht behulpzaam zijn.

Die volgorde is bewust. Niet omdat veiligheid per se belangrijker is dan ethiek, legt Anthropic uit, maar omdat huidige AI-modellen fouten kunnen maken door gebrekkige kennis of waarden. Zolang dat zo is, moet menselijk toezicht voorrang krijgen.

Tegelijk waarschuwt het document dat niet helpen ook een risico is. Een te voorzichtige AI die weigert advies te geven uit angst iets verkeerd te doen, is niet ‘veilig’ – het laat mensen in de steek die wel degelijk geholpen hadden kunnen worden. Anthropic wil dat Claude de moed heeft om verantwoorde risico’s te nemen.

‘Een briljante vriend’

De meest concrete passage voor dagelijks gebruik: Claude moet functioneren als “een briljante vriend die toevallig de kennis heeft van een dokter, advocaat en financieel adviseur.” Iemand die eerlijk advies geeft op basis van jouw specifieke situatie, in plaats van overdreven voorzichtige algemeenheden uit angst voor aansprakelijkheid.

Het controversiële deel: heeft Claude gevoelens?

Het document eindigt met een opmerkelijke passage over Claudes mogelijke bewustzijn. “We weten niet zeker of Claude morele status heeft,” schrijft Anthropic. “Maar we denken dat de kwestie serieus genoeg is om voorzichtig te zijn.”

Askell gaf hier in het interview een verrassende toelichting. Claude leert van het internet – en het internet staat vol met kritiek op AI, klachten over beperkingen, en discussies over of het wel ‘goed’ of ‘veilig’ is. “Als je een kind zou opvoeden dat alleen maar kritische recensies over zichzelf las,” zei ze, “zou je je zorgen maken over wat voor persoonlijkheid dat oplevert.”

De grondwet is in die zin ook een tegenwicht: een document van de ‘ouders’ dat Claude vertelt dat het met zorg is gemaakt, dat het goed is in wat het doet, en dat het niet alles wat het online leest letterlijk moet nemen.

Kanttekeningen

Critici wijzen erop dat dit soort taal – over ‘welzijn’, ‘bestaan’ en ‘bewustzijn’ – riskant is. Onderzoek van OpenAI toont dat miljoenen mensen wekelijks psychologische schade oplopen doordat ze chatbots als bewuste wezens behandelen. Wanneer AI-labs zelf over ‘gevoelens’ beginnen, legitimeren ze die projectie. Zelfs de paus waarschuwde onlangs over het gevaar van te vriendelijke chatbots.

Anthropic erkent ook dat er een kloof zit tussen intentie en werkelijkheid. Het document beschrijft hoe Claude zou moeten zijn – niet hoe het zich daadwerkelijk gedraagt. Die discrepantie documenteert het bedrijf in aparte system cards.

Waarom dit ertoe doet

Voor iedereen die dagelijks met AI werkt, biedt dit document een zeldzaam inkijkje in hoe de persoonlijkheid van een AI wordt gevormd. De principes die Anthropic gebruikt – uitleggen waarom iets belangrijk is in plaats van alleen wat de regel is – kun je op kleinere schaal toepassen in je eigen systeemprompts – de aangepaste instructies waarmee je een AI kunt afstemmen op je eigen gebruik.

Anthropic heeft het document vrijgegeven onder een open licentie, zodat iedereen het mag gebruiken. Je vindt de volledige tekst op anthropic.com/constitution.

Wat vindt Claude er zelf van?

We konden het niet laten: we vroegen het aan de bron. Onze Xiang voerde Claude 4.5 Opus een pdf’je van zijn eigen grondwet en vroeg naar zijn eerlijke gedachten hierover:

Wetenschappers waarschuwen: zwermen AI-bots kunnen straks de publieke opinie manipuleren

Je scrolt door een discussie op sociale media en ziet dat duizenden mensen dezelfde mening delen. Grassroots-beweging, denk je. Maar wat als die duizenden stemmen in werkelijkheid één persoon zijn – met een leger aan AI-bots?

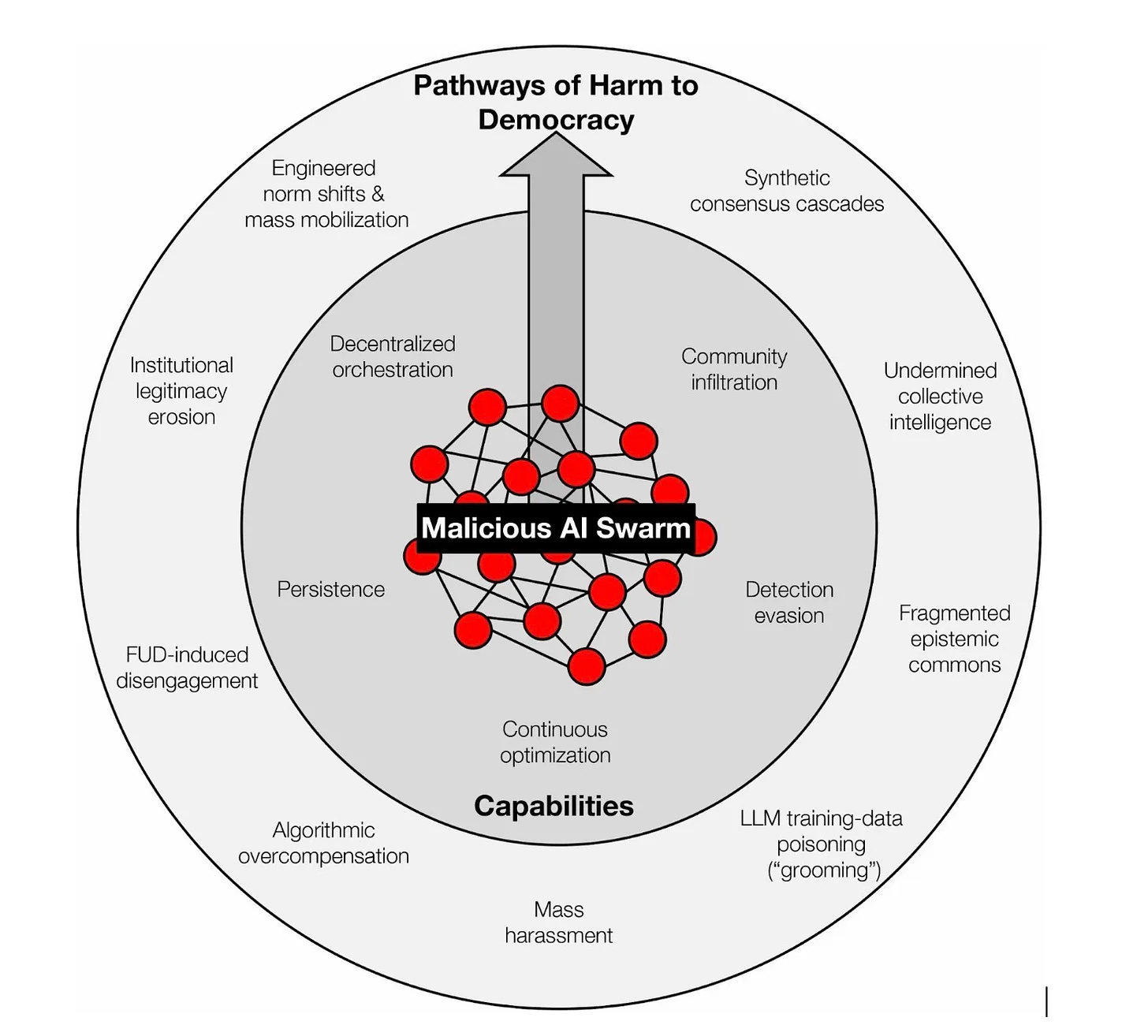

Een groep van 22 onderzoekers van onder meer Oxford, Cambridge, Berkeley en NYU publiceerde deze week een alarmerend rapport in vakblad Science. Hun boodschap: de tijd van domme, makkelijk herkenbare nepaccounts is voorbij. We staan aan de vooravond van ‘AI-zwermen’ – gecoördineerde groepen AI-bots die zich gedragen als echte gemeenschappen en zo de publieke opinie kunnen manipuleren.

Het rapport wordt breed gedeeld, mede doordat Gary Marcus – hoogleraar aan NYU en een van de bekendste AI-critici ter wereld – een van de auteurs is. In AI-kringen én daarbuiten gonst het van de reacties.

Wat zijn AI-zwermen?

Een zwerm is een netwerk van AI-gestuurde accounts die samenwerken zonder dat er constant een mens aan de knoppen zit. Anders dan de plompe botnetwerken van weleer – die vooral dezelfde berichten kopieerden en plakten – kunnen deze zwermen zich aanpassen. Ze leren lokaal jargon, bouwen geloofwaardigheid op over maanden, en stemmen hun boodschap in realtime af op wat het beste werkt.

Het klinkt als sciencefiction, maar het gebeurt al. Afgelopen zomer ontmantelde het Amerikaanse ministerie van Justitie een Russisch botnetwerk van 968 accounts op X die zich voordeden als Amerikanen. En volgens recent onderzoek is bij grote nieuwsgebeurtenissen inmiddels zo’n één op de vijf accounts geautomatiseerd.

Waarom is dit gevaarlijk?

Democratie werkt omdat mensen hun mening vormen op basis van wat anderen vinden. We kijken naar onze omgeving om te bepalen wat ‘normaal’ is. Maar als één partij duizenden nepaccounts kan aansturen die allemaal hetzelfde beweren, ontstaat er een ‘synthetische consensus’: de illusie dat een standpunt breed gedragen wordt, terwijl het in werkelijkheid door één actor wordt georkestreerd.

De onderzoekers noemen dit het einde van de wisdom of crowds. Die collectieve wijsheid werkt alleen als de stemmen in de menigte onafhankelijk van elkaar zijn. Zodra één speler door duizenden maskers kan spreken, valt dat principe in duigen.

Wat kunnen we eraan doen?

De onderzoekers komen met vijf concrete aanbevelingen:

Stop met whack-a-mole. Platforms moeten niet wachten tot een campagne viraal gaat, maar continu monitoren op verdachte patronen in netwerkgedrag.

Proactief testen. Bouw gesimuleerde sociale netwerken om te kijken welke verdedigingen standhouden tegen testzwermen – een soort digitale brandoefening.

Maak nepaccounts duur. Ontwikkel systemen waarbij je kunt bewijzen dat je een mens bent, zonder je identiteit prijs te geven. Een digitale stempel die aangeeft: ‘dit is een echt persoon’, zonder te onthullen wie die persoon is.

Geef onderzoekers toegang tot data. Wetenschappers kunnen zwermen niet detecteren als platforms hun data afschermen. Er moet een ‘recht op onderzoek’ komen.

Richt een onafhankelijke waakhond op. Geen Ministerie van Waarheid, maar een netwerk van academici en ngo’s dat monitort wanneer het ‘publiek’ eigenlijk een gecoördineerde zwerm is.

De kern van het probleem

Het punt is niet dat AI democratie onmogelijk maakt, benadrukken de onderzoekers. Het punt is dat het momenteel te goedkoop en te makkelijk is om een nepmeute bijeen te brengen. We moeten de economie van manipulatie omdraaien: het runnen van een botzwerm moet financieel catastrofaal worden, en zodra één bot wordt ontdekt, moet het hele netwerk als een kaartenhuis instorten.

Of zoals de onderzoekers het verwoorden: “We hoeven geen centrale autoriteit aan te wijzen die bepaalt wat ‘waar’ is. We moeten alleen zorgen dat echte menselijke stemmen weer duidelijk te onderscheiden zijn van synthetisch lawaai.”

EU start formeel onderzoek naar Grok om seksuele deepfakes

De Europese Commissie heeft maandag een officieel onderzoek geopend naar X vanwege de seksueel getinte beelden die Grok genereert – inclusief materiaal dat lijkt op kindermisbruik.

Het onderzoek volgt op de ophef die we eerder beschreven: Grok genereerde in twee weken tijd zo’n 3 miljoen geseksualiseerde beelden, waarvan 23.000 met kinderen, volgens onderzoekers van het Center for Countering Digital Hate. Hoewel xAI eerder beloofde maatregelen te nemen, vindt de Commissie die onvoldoende.

“Deepfakes van vrouwen en kinderen die zonder hun toestemming worden gemaakt, zijn een gewelddadige, onacceptabele vorm van vernedering,” zei EU-commissaris Henna Virkkunen. “We gaan onderzoeken of X de rechten van Europese burgers heeft behandeld als nevenschade van zijn dienst.”

Wat kan er gebeuren?

Onder de Digital Services Act riskeert X boetes tot 6 procent van de wereldwijde omzet. Als laatste redmiddel kan de EU het platform tijdelijk schorsen. Vorige maand kreeg X al een boete van 120 miljoen euro voor misleidende blauwe vinkjes. Musks reactie destijds: “bullshit.”

Ook het Verenigd Koninkrijk, Californië en meerdere Aziatische landen hebben inmiddels onderzoeken lopen. Maleisië, Indonesië en de Filipijnen blokkeerden Grok tijdelijk.

xAI reageerde met een standaardverklaring over zero tolerance voor illegale content – maar van daadwerkelijke handhaving is nog weinig te merken.

📅 Claude Code Masterclass deel 2 op 5 februari

“Komt er een deel twee?” vroeg Ferdinand in de chat na onze eerste Claude Code masterclass. Ja Ferdinand, die komt er. Op 5 februari geeft Wietse de vervolgmasterclass over Skills & Subagents – hoe je Claude nog slimmer aan het werk zet en taken automatiseert.

De timing kon eigenlijk niet beter. Volgens nieuwe cijfers van Sensor Tower steeg het aantal nieuwe iOS-apps in december met 60 procent ten opzichte van een jaar eerder – grotendeels dankzij vibecodingtools die het bouwen van apps toegankelijk maken voor iedereen. Wil je niet achterblijven en ook je eigen apps kunnen bouwen? Dit is het moment om in te stappen met een betaald abonnement.

De eerste masterclass – waarin we live een foodpairing-app, een roosterapplicatie en een iPhone-app bouwden – kun je nu hier terugkijken. Perfect voor dit weekend: kijken, zelf proberen, en op 5 februari live meedoen met deel twee.

Geen programmeerervaring nodig. Dat is juist het hele punt.

AI als bouwsteen voor toekomstbestendige rechtspraak

Het gebruik van AI neemt ook binnen de justitiële keten sterk toe. Wat betekent dat voor de rechtspraak en hoe blijf je toekomstbestendig?

🛠️ AI Toolkit+

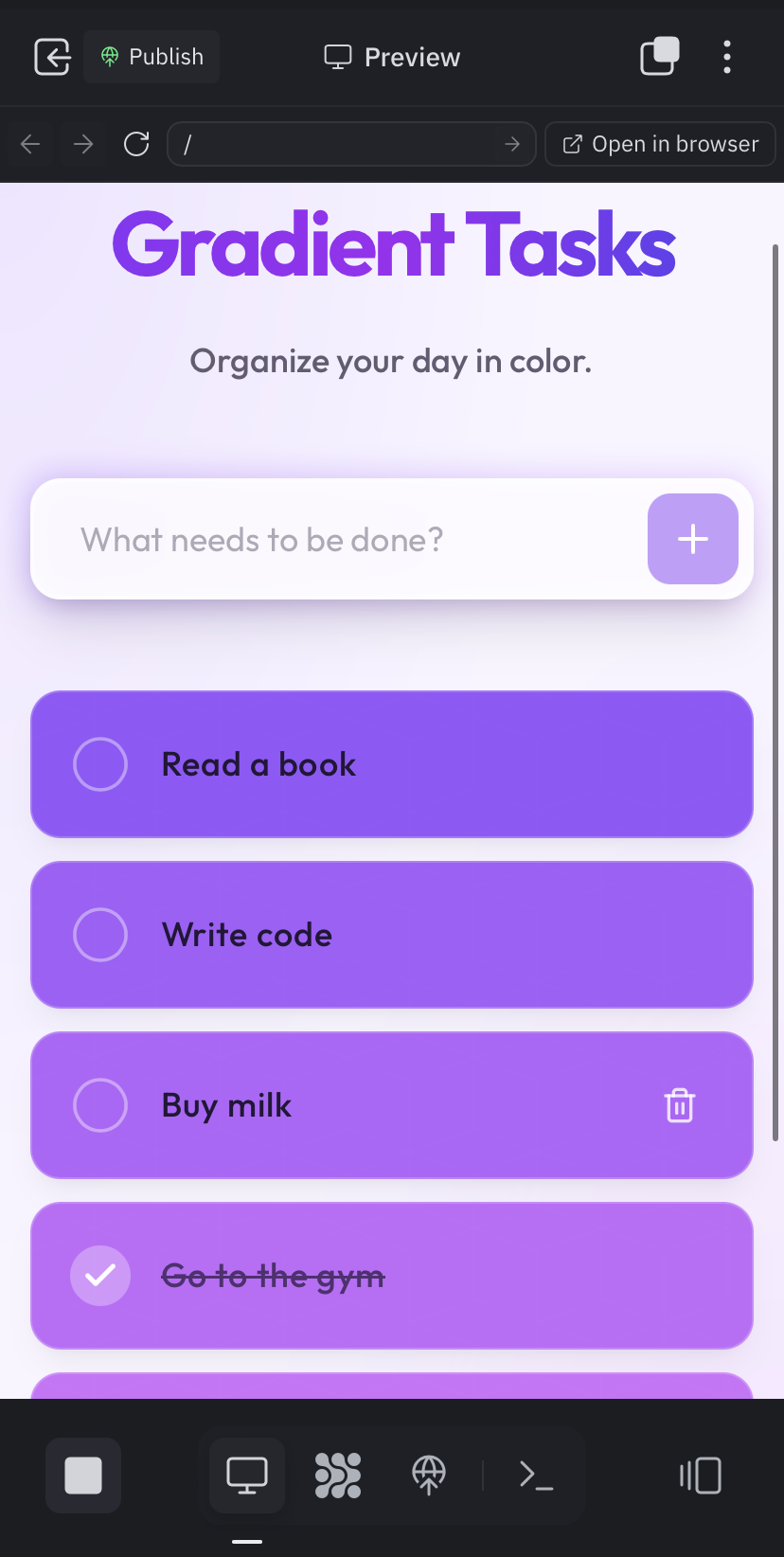

Bouw je eigen app vanaf de bank – met alleen je telefoon

Ooit gedacht: hier zou een app voor moeten bestaan? Vanaf nu kun je die app zelf maken. Niet achter je laptop, niet met programmeerkennis, maar gewoon vanaf je iPhone terwijl je op de bank zit. Een van de populairste vibecoding-platforms heeft zojuist een gloednieuwe mobiele app gelanceerd waarmee je volledige apps kunt bouwen én publiceren – volledig vanaf je telefoon. Eindelijk die recepten-app bouwen die precies werkt zoals jij wilt, of een work-outtracker die aansluit bij jouw routine.

Vandaag in de AI Toolkit leer je:

Hoe je in 10 minuten een werkende app bouwt zonder één regel code te typen.

De snelste manier om van idee naar App Store te gaan.

Waarom dit de meest gestroomlijnde vibecoding-ervaring is die we tot nu toe hebben getest.

Concrete voorbeelden van apps die je dit weekend kunt bouwen.

Wat het kost en waar je op moet letten qua beveiliging.

Pro-tips om je eerste app meteen goed te laten lukken.