Jouw ChatGPT-gesprekken zijn straks bewijsmateriaal

PLUS: Apple maakt lokale AI toegankelijk, en zo maak je spetterende slides met één druk op de knop

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

De dataoorlog: OpenAI en Anthropic onder vuur

De angst dat onze gesprekken met AI niet volledig privé zijn, heeft een nieuwe, concrete dimensie gekregen. Het gaat niet langer alleen om het risico dat je data worden ingezien of gebruikt voor training; een Amerikaanse rechter heeft nu bepaald dat zelfs je verwijderde chats als bewijsmateriaal kunnen dienen in een rechtszaak.

De ‘goudkoorts’ naar data, de brandstof van de AI-revolutie, heeft nu de rechtbank bereikt. Tijdens deze rechtszaken zullen de komende tijd de spelregels bepaald worden - niet door techneuten in Silicon Valley, maar door advocaten.

Wat is er aan de hand?

Twee rechtszaken staan centraal en raken de kern van hoe AI-bedrijven met data omgaan:

OpenAI moet alles bewaren: een Amerikaanse rechter heeft OpenAI bevolen om alle ChatGPT-logs te bewaren, inclusief gesprekken die gebruikers dachten te hebben verwijderd. De reden? The New York Times, die OpenAI aanklaagt voor copyrightschending, vreest dat gebruikers hun paywall omzeilen via ChatGPT en daarna hun sporen wissen. Volgens de rechter weegt dit potentiële bewijsmateriaal zwaarder dan de privacy van honderden miljoenen gebruikers.

Reddit klaagt Anthropic aan voor datadiefstal: Reddit sleept AI-bedrijf Anthropic (de maker van Claude) voor de rechter. Anthropic zou, tegen de regels in, meer dan 100.000 keer content van het platform hebben geschraapt om zijn modellen te trainen. Reddit, dat eerder voor 60 miljoen dollar per jaar een datadeal sloot met Google, stelt dat zijn ‘authentieke menselijke gesprekken’ miljarden waard zijn en niet zomaar gestolen mogen worden.

De lastige positie van AI-bedrijven: privacy als schild

De reactie van OpenAI op het bevel is veelzeggend. Het bedrijf verzet zich met hand en tand, en stelt in een felle verklaring dat de uitspraak hen dwingt de privacykeuzes van gebruikers te negeren, wat schadelijk is voor het vertrouwen. De privacykaart wordt volop gespeeld.

Maar hier wordt pijnlijk zichtbaar in wat voor spagaat het bedrijf zich bevindt. Terwijl OpenAI zich publiekelijk opwerpt als verdediger van gebruikersprivacy, is hun hele businessmodel afhankelijk van toegang tot enorme hoeveelheden data. Dit conflict tussen de publieke houding en de commerciële noodzaak wordt nog complexer door de Europese wetgeving.

En OpenAI is niet de enige die in deze spagaat zit. Concurrent Anthropic, die zich graag profileert als de ethische, verantwoorde optie, wordt door Reddit juist weggezet als een bedrijf met twee gezichten. De aanklacht wegens datadiefstal laat zien dat de ethische beloftes van AI-labs vooral lijken te gelden tot ze de commerciële noodzaak voor meer data in de weg zitten.

De uitspraak tegen OpenAI creëert een juridisch mijnenveld, vooral voor Europese gebruikers. Het Amerikaanse bevel botst namelijk direct met de Europese AVG, die ons het recht geeft ‘om vergeten te worden’. OpenAI zit klem tussen een Amerikaans rechterlijk bevel en Europese privacyrechten.

Voor wie geldt dit bevel nu concreet?

Wel getroffen: gebruikers van de consumentenversies ChatGPT Free, Plus en Pro. Voor deze groepen worden nu alle logs bewaard, óók als je handmatig gesprekken verwijdert, een Temporary Chat gebruikt, of zelfs je hele account wist. Ook gebruik via de API wordt meegenomen, tenzij er Zero Data Retention beleid is afgestemd.

Niet (of minder) getroffen: ChatGPT Enterprise en ChatGPT Edu gebruikers. Voor hen blijven de bestaande contractuele afspraken over dataopslag en -verwijdering van kracht. Dit bevel is primair gericht op de individuele gebruiker.

Voorlopig lijkt het erop dat de Amerikaanse uitspraak de standaard wordt. OpenAI vecht het bevel wel aan, maar tot die tijd is de boodschap duidelijk: voor de meeste gebruikers is ‘verwijderd’ niet meer echt verwijderd.

🎥 Donderdag: AI Report Webinar

Het is weer bijna zover! Deze donderdag 12 juni van 12:00 tot 13:00 uur, vindt ons derde AI Report Webinar plaats. Elke sessie beantwoorden Alexander Klöpping en Wietse Hage een uur lang jouw prangende AI-vragen. Je krijgt een uniek kijkje in hun dagelijkse praktijk. Ze delen niet alleen hun eigen ervaringen en handige tips, maar gaan vooral in op zaken waar jij tegenaan loopt. Dit is je kans om al je vragen te stellen aan twee experts die dagelijks met deze tools werken.

Als betalend abonnee krijg je automatisch toegang – je ontvangt een mailtje met alle details en een kalenderuitnodiging.

Nog geen abonnee? Op aireport.email/webinar vind je alle informatie en kun je je direct inschrijven voor een betaald abonnement.

Apple maakt lokale AI toegankelijk voor app-ontwikkelaars

Wietse en Alexander hadden het er vorige week uitgebreid over in de podcast: AI die volledig op je telefoon draait in plaats van in de cloud. Nu zet Apple een belangrijke stap door ontwikkelaars toegang te geven tot precies die technologie. Met het nieuwe Foundation Models Framework kunnen apps straks gebruikmaken van dezelfde slimme functies als Apples eigen software – maar dan zonder dat je data je telefoon verlaten.

Wat betekent lokale AI eigenlijk?

Zoals Wietse in de podcast uitlegde: “de meeste AI-apps sturen je gegevens naar servers van techbedrijven. Je typt een vraag in ChatGPT? Die gaat naar OpenAI’s servers. Je gebruikt Grammarly? Je tekst wordt geanalyseerd in de cloud.”

Apple kiest voor een andere aanpak. De AI-modellen draaien gewoon op je iPhone of Mac, net zoals je camera-app dat doet. Geen internetverbinding nodig, geen data die je apparaat verlaten. Het framework dat Apple nu uitrolt, maakt het voor elke app-ontwikkelaar mogelijk om deze lokale AI te gebruiken.

Van technische nachtmerrie naar drie regels code

Tot nu toe was lokale AI in iPhone-apps extreem complex. Elke ontwikkelaar moest het wiel opnieuw uitvinden: eigen modellen zoeken, converteren, optimaliseren. Voor ontwikkelaars was een cloudoplossing daarom de enige realistische keuze.

Apples oplossing is elegant: de AI-modellen die toch al op je iPhone staan voor Apple Intelligence, worden nu ook beschikbaar voor andere apps. Het Foundation Models Framework geeft ontwikkelaars toegang tot deze modellen. In plaats van dat elke app zijn eigen AI meebrengt, kunnen ze nu met drie regels Swift-code communiceren met Apples modellen.

Wat kun je er wel en niet mee?

Zoals in de podcast besproken: lokale modellen die op een telefoon draaien zijn kleiner dan de grote cloudmodellen zoals GPT-4o of Claude Sonnet 4. Logisch ook – je telefoon heeft nu eenmaal minder rekenkracht dan een datacenter vol servers. Maar voor veel dagelijkse taken is die extreme intelligentie helemaal niet nodig.

Wat werkt uitstekend:

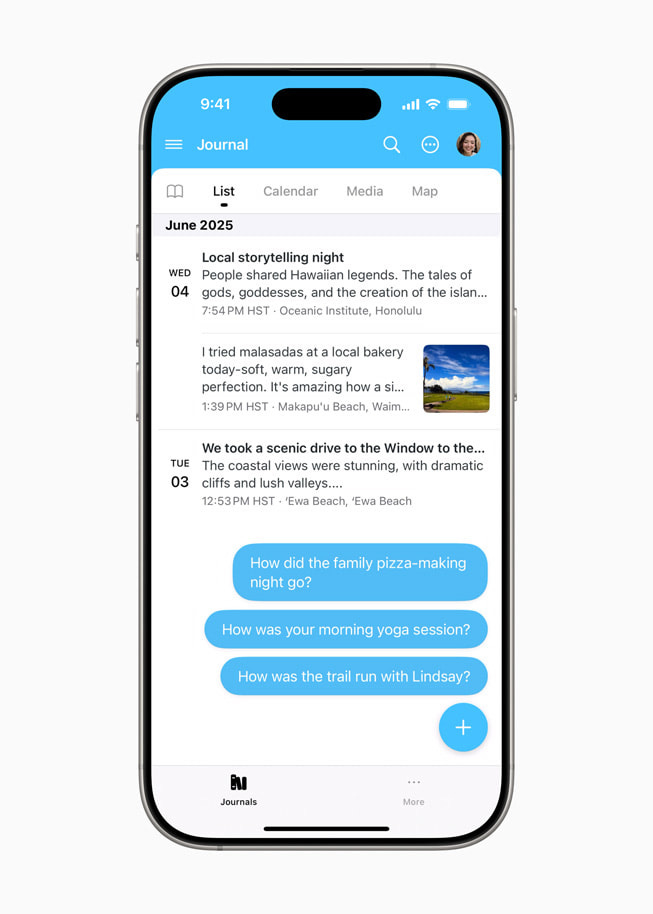

Een dagboek-app die schrijfsuggesties geeft (zoals Day One nu doet).

Een wandel-app die routes aanbeveelt op basis van je voorkeuren.

Een studie-app die automatisch samenvattingen maakt van je notities.

Een foto-app die je collectie doorzoekbaar maakt met natuurlijke taal.

Wat blijft lastig:

Het schrijven van complete onderzoeksrapporten of businessplannen.

Het genereren van lange, gedetailleerde stukken tekst.

Taken die veel algemene kennis vereisen.

Privacy als selling point

Het mooiste aan deze aanpak? Je notities voor dat belangrijke tentamen blijven op je telefoon. Die persoonlijke dagboekfragmenten? Niemand anders dan jij leest ze. Je wandelroutes en foto’s? Blijven privé.

Dit staat lijnrecht tegenover de situatie waarin OpenAI zich bevindt, nu het gedwongen wordt gebruikersinformatie op te slaan in eigen datacenters.

Wat betekent dit voor jou?

Verwacht als Apple gebruiker de komende maanden een golf van apps die ineens een stukje slimmer worden – zonder dat je privacy hoeft in te leveren. Denk hierbij vooral aan slimme suggesties voor schrijven en zoeken van tekst, het samenvatten van tekst en handigere functies rond het analyseren van afbeeldingen. Het framework is vanaf vandaag beschikbaar voor ontwikkelaars, met een publieke bèta volgende maand.

Verwacht dus niet een nieuwe variant van ChatGPT die lokaal draait en mee kan komen met de grote cloudmodellen, maar wel een hoop slimme functies die direct zijn geïntegreerd in de apps waar je al bekend mee bent.

⚡ AI Pulse

Mistral lanceert AI-codingassistent die code binnen bedrijfsmuren houdt. Na OpenAI en Anthropic komt nu ook Mistral met een codingassistent, maar wel een met een cruciale twist: alle code blijft binnen je eigen bedrijf. Geen enkele regel verlaat het gebouw. Voor banken en overheden die hun broncode niet naar Amerikaanse clouds willen sturen, is dit een doorbraak. Franse spoorwegen SNCF gebruikt het al voor 4000 ontwikkelaars. Spaanse bank Abanca draait een hybride setup: prototypes in de cloud, kritieke bankcode on-premise. Zoals Wietse in de podcast al aangaf: “het draait niet alleen om het hebben van het slimste model, maar ook om andere factoren, zoals veiligheid”.

MIT-start-up leert AI om “ik weet het niet” te zeggen. Themis AI pakt een fundamenteel probleem aan: AI-systemen die altijd een antwoord verzinnen, ook als ze het niet weten. Hun Capsa-platform geeft AI-modellen zelfbewustzijn over hun eigen beperkingen. Het begon met onderzoek naar zelfrijdende auto’s voor Toyota, een sector waarin gokken dodelijk kan zijn. Hun algoritme spoort niet alleen vooroordelen op, maar corrigeert die ook automatisch. Nu helpen ze farmaceuten om alleen medicijnen te ontwikkelen waar de AI zeker van is. Door te weten wanneer het model onzeker is, kunnen fouten in kritische situaties voorkomen worden.

China zet AI uit tijdens nationale examens. Meer dan 13 miljoen Chinese studenten maken deze week hun gaokao-examens, en techbedrijven nemen drastische maatregelen. Alibaba’s Qwen, ByteDances Doubao en Tencents Yuanbao hebben hun beeldherkenning uitgeschakeld – geen examenvragen beantwoorden tot de toetsen voorbij zijn. DeepSeek blokkeert zelfs zijn complete service tijdens examenuren. Terwijl Amerikaanse universiteiten worstelen met AI-fraude en massaal terugkeren naar pen en papier, kiest China voor de directe aanpak: gewoon de stekker eruit.

🛠️ AI Toolkit+

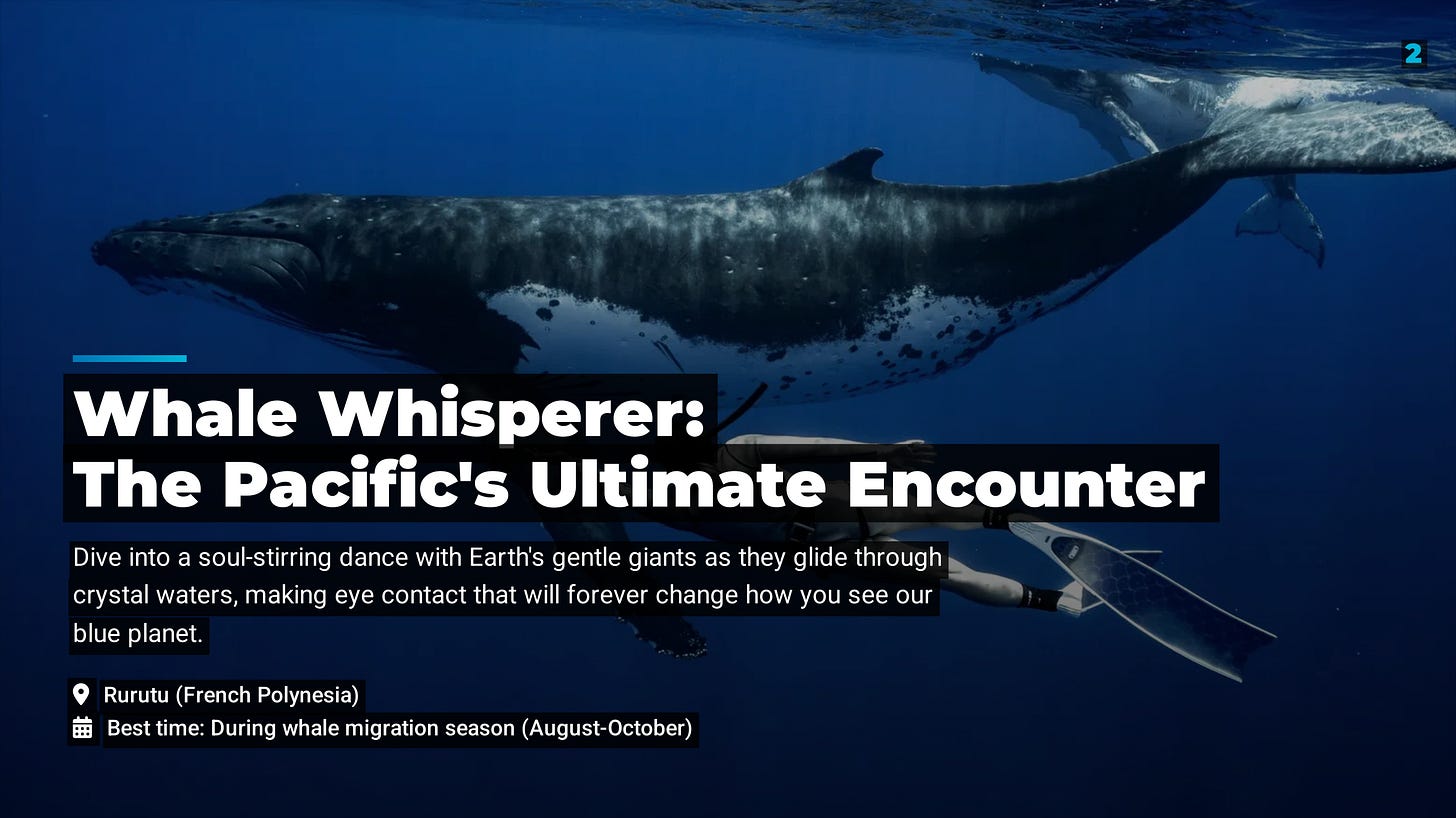

Van idee naar presentatie met één druk op de knop

Mooi hè, die slides hieronder? Alleen al bij het zien ervan krijg je zin om je backpack te pakken. Nog mooier: de complete presentatie – van avontuurlijke bestemmingen tot hero-foto’s en strakke lay-out – ontstond uit één enkele prompt. Geen uren zoeken naar stockfoto’s, geen gepruts met templates: de AI deed álles. Benieuwd hoe je ook zoiets kunt maken? Vandaag laten we je stap-voor-stap zien hoe je zelf een volwaardig deck maakt met één druk op de knop.

Wat krijg je vandaag?

de beste AI-presentatiegenerator op de markt;

een exclusieve kijk in Xiangs complete testproces (met screenshots van elke stap);

de slimme promptmethode die het verschil maakt;

eerlijke bevindingen over wat wel en niet werkt;

een onverwachte valkuil waar je op moet letten;

concrete tips om vandaag nog aan de slag te gaan.