Kraak de moeilijkste problemen met deze prompttechniek

PLUS: Apple onderzoekt of AI echt kan nadenken, Meta koopt voor $15 miljard een plek in de AGI-race, en hoe Mistral met privacy de Europese markt verovert

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

💡 Vandaag: AI Report-webinar!

Over een halfuur gaan we live met Alexander en Wietse! Ze beantwoorden een uur lang al je AI-vragen en delen hun dagelijkse ervaringen, rechtstreeks vanuit de Amsterdamse studio.

Als betalend abonnee krijg je automatisch toegang – onderaan deze mail vind je de link naar de meeting. Nog geen lid? Voor een tientje per maand ben je verzekerd van je plek bij alle webinars én ontvang je twee keer per week onze volledige nieuwsbrief.

Tot zo!

🗞️ Het belangrijkste nieuws

Apple ‘bewijst’ dat AI niet kan denken - of toch niet?

Kan een AI echt redeneren, of is het gewoon een extreem geavanceerde papegaai? Te midden van de AI-hype probeert Apple een kritische noot te kraken met hun paper The Illusion of Thinking. De conclusie die de media gretig overnam: AI kan niet écht redeneren. Opvallend genoeg komt deze boodschap van het bedrijf dat van alle grote techgiganten het meest achterloopt op AI-gebied.

Het onderzoek richt zich specifiek op reasoningmodellen, zoals de o-serie van OpenAI en DeepSeek R1. Deze modellen werken anders dan gewone chatbots: ze produceren eerst een lange reeks ‘gedachten’ waarin ze verschillende oplossingen verkennen, fouten herkennen en hun aanpak bijstellen voordat ze een definitief antwoord geven. Op benchmarks voor wiskunde en programmeren presteren dit soort modellen aanzienlijk beter dan de modellen die dit niet doen. Apple wilde onderzoeken of dit werkelijk komt door beter redeneren, of dat er iets anders aan de hand is.

De puzzeltest

De onderzoekers van Apple lieten AI-modellen puzzels oplossen, waaronder de klassieke ‘Toren van Hanoi’, waarbij schijven in een bepaalde volgorde verplaatst moeten worden. Ze vergeleken standaardmodellen met reasoningmodellen bij verschillende moeilijkheidsgraden.

Hun bevindingen:

Bij simpele puzzels (1-3 schijven): standaardmodellen deden het even goed of zelfs beter. Reasoningmodellen hadden last van overthinking.

Ze vonden vaak eerst het juiste antwoord, maar bleven doordenken en kozen uiteindelijk een fout antwoord.

Bij middelzware puzzels (4-7 schijven): hier wonnen reasoningmodellen duidelijk van standaardmodellen.

Bij complexe puzzels (10+ schijven): alle modellen faalden volledig.

Het meest opvallende was wat er gebeurde bij die complexe puzzels. In plaats van harder hun best te doen, begonnen reasoningmodellen juist minder ‘denkwerk’ te produceren. Ze gaven het op.

Een problematische test

Maar er kleven fundamentele problemen aan Apples aanpak. De Toren van Hanoi is een beroemde puzzel waarvan de oplossing letterlijk duizenden keren in AI-trainingsdata voorkomt. Het test dus niet zozeer redeneervermogen als wel het vermogen om bekende patronen te herkennen. Dit is ook bekend onder de term ‘contaminatie’, waarbij de testdata in de trainingsdata van een model beland. Het is alsof je iemands intelligentie test door ze een kruiswoordpuzzel te laten oplossen die ze vorige week al hebben ingevuld.

Bovendien is wat Apple ‘opgeven’ noemt mogelijk een teken van intelligentie. Een puzzel met 10 schijven vereist 1023 exacte stappen. Wanneer moderne AI-modellen dit herkennen, proberen ze vaak een algemene oplossing te vinden in plaats van stug alle stappen uit te schrijven, wat in sommige gevallen juist een slimmere aanpak is. Apples onderzoek toont vooral aan dat we nog geen goede manier hebben om AI-intelligentie te meten. Het gebruiken van puzzels waarvan de oplossing al in de trainingsdata zit, vertelt ons weinig over werkelijk redeneervermogen.

Wat betekent dit nu echt?

Tegelijkertijd legt het onderzoek wel een interessant fenomeen bloot: reasoningmodellen kunnen zichzelf in de weg zitten bij simpele taken. Hun sterkte – het systematisch verkennen van oplossingen – wordt een zwakte wanneer het probleem eigenlijk straightforward is. Of hybridemodellen, zoals Claude Sonnet 4, hiervoor de oplossing bieden is jammer genoeg niet onderzocht.

Of deze modellen nu ‘echt’ redeneren of zeer geavanceerde patroonherkenning toepassen, blijft een open vraag. Maar praktisch gezien worden de resultaten op complexe taken zoals wiskunde en programmeren steeds indrukwekkender. Apples poging om de hype te temperen is waardevol, maar de test schiet tekort om definitieve conclusies te trekken over wat AI wel of niet kan.

Meta’s wanhoopsoffensief: $15 miljard voor datakoning Scale AI

De AI-wedloop is een spel van miljarden geworden, en Meta, dat bang is de boot te missen, trekt nu de portemonnee. Het bedrijf staat op het punt bijna $15 miljard te investeren in Scale AI, een van de belangrijkste leveranciers van trainingsdata ter wereld.

Wat is er aan de hand?

Scale AI is de onzichtbare motor achter vrijwel alle grote AI-labs. OpenAI, Anthropic, Google - ze vertrouwen allemaal op Scale voor het labelen en cureren van trainingsdata. Door bijna de helft van dit bedrijf te kopen, wordt Meta niet alleen klant maar ook mede-eigenaar van de infrastructuur waar concurrenten van afhankelijk zijn.

Volgens The Information krijgt Meta met de deal een belang van 49% in Scale AI. Maar de échte prijs is misschien wel de CEO van Scale, Alexandr Wang. Hij zal naar verluidt toetreden tot een speciaal team, persoonlijk samengesteld door Mark Zuckerberg, met maar één doel: het bereiken van Artificial General Intelligence (AGI).

Van koploper naar achtervolger

Lange tijd was Meta’s Llama-serie de onbetwiste koning van de open source AI-wereld. Maar met Llama 4 is die voorsprong verdampt. Concurrenten als Qwen, DeepSeek en het Franse Mistral brengen in een moordend tempo modellen uit – van klein tot groot – die de verschillende Llama 4 modellen evenaren of zelfs voorbijstreven. In mei stelde Meta de lancering van zijn nieuwe topmodel Behemoth nog uit, een teken dat niet alles volgens plan verloopt.

Nu Meta’s voorsprong is geslonken, lijkt het bedrijf zijn strategie aan te passen. Het gaat al een tijdje niet meer alleen om wie de meeste GPU’s bezit - kennis en talent maken het verschil. Deze deal van 15 miljard dollar voor Scale AI en zijn CEO Alexandr Wang bewijst dat Meta die les heeft geleerd, tegen een flinke prijs.

Vergeet de slimste AI: hoe Mistral de privacykaart speelt

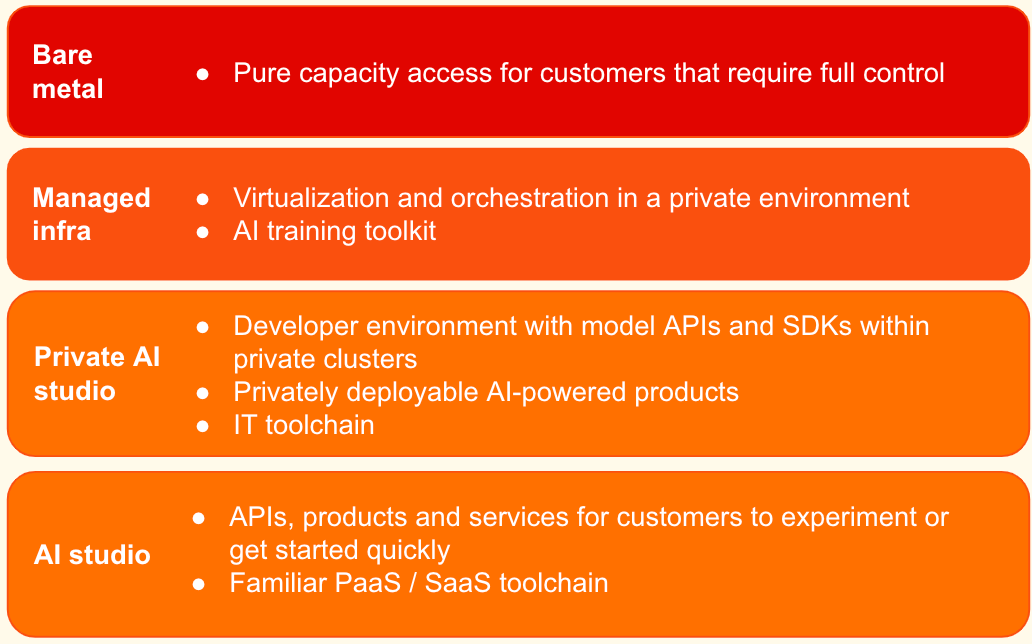

Terwijl techreuzen als OpenAI en Google elkaar bestrijden met steeds grotere en slimmere modellen, maakt de Franse AI-lieveling Mistral een onverwachte draai. In plaats van vol in te zetten op de benchmark-race, richten ze hun pijlen nu ook op de infrastructuur. Met de aankondiging van Mistral Compute bieden ze, in samenwerking met NVIDIA, een compleet AI-ecosysteem als dienst aan.

Deze strategische verbreding is een slim antwoord op een markt die wordt gedomineerd door Amerikaanse en Chinese spelers. Mistral heeft een unieke positie, het is de enige Europese partij die kwalitatief goede modellen en gebruikerssoftware maakt. Door de samenwerking met NVIDIA is Mistral in staat een full-stack oplossing aan te bieden; van hardware en modellen tot de chatinterface.

Hiermee openen ze een compleet nieuwe markt: overheden, bedrijven en onderzoeksinstituten die uit soevereiniteitsoverwegingen een betrouwbare en onafhankelijke oplossing zoeken en hun data niet bij Amerikaanse partijen willen onderbrengen. Dat ze tegelijkertijd topmodellen als het recente Magistral blijven uitbrengen, bewijst dat ze aardig met de grote jongens kunnen meekomen.

🔮 Prompt whisperer

Atom-of-Thoughts: kraak de moeilijkste problemen met deze prompttechniek

Stel je voor dat je een ingewikkeld vraagstuk moet oplossen - bijvoorbeeld het berekenen van de optimale prijs voor je nieuwe product, rekening houdend met productiekosten, concurrentie én seizoensinvloeden. Je hoofd tolt van alle factoren die je moet meewegen. Wat doe je? Waarschijnlijk pak je het probleem stap voor stap aan, waarbij je eerst de losse onderdelen uitwerkt voordat je ze samenvoegt tot een antwoord.

Precies deze aanpak ligt ten grondslag aan Atom-of-Thoughts (AoT), de nieuwste aanwinst in het groeiende arsenaal van prompttechnieken. Waar de bekende Chain-of-Thought-methode AI vraagt om stap voor stap te redeneren, gaat AoT een stap verder: het leert AI om complexe problemen eerst op te delen in de kleinst mogelijke, onafhankelijke ‘atomen’ van denken. Het resultaat? Snellere, nauwkeurigere antwoorden én minder hallucinaties. Vandaag leren we jou hoe jij met deze techniek in je toolkit de moeilijkste problemen kunt kraken.

Waarom is dit belangrijk?

De meeste AI-systemen worstelen met complexe vraagstukken omdat ze alles tegelijk proberen op te lossen - als een jongleur die te veel ballen in de lucht houdt. Onderzoekers testten AoT op zes verschillende benchmarks en de resultaten zijn indrukwekkend: bij wiskundige problemen (MATH dataset) steeg de nauwkeurigheid van 78,3% naar 83,6%. Bij complexe multi-hop redeneertaken - waarbij AI informatie uit verschillende bronnen moet combineren - waren de verbeteringen nog spectaculairder. Op de HotpotQA benchmark behaalde het oudere model GPT-4o mini met AoT een F1-score van 80,6%, wat zelfs OpenAI’s nieuwere o3-mini model (77,2%) en DeepSeek-R1 (70,0%) overtreft.

Het meest opvallende aan het onderzoek is de efficiëntiewinst. Traditionele methoden verspillen veel rekenkracht aan het bijhouden van alle tussenstappen. AoT daarentegen focust alle computerkracht op het huidige deelprobleem, wat volgens de onderzoekers leidt tot een “aanzienlijke reductie van verspilde rekenkracht op historische informatie”.

Voor professionals betekent dit concreet: minder tijd besteden aan het controleren van AI-output, betrouwbaardere analyses en de mogelijkheid om complexere vraagstukken aan AI toe te vertrouwen. Of je nu een marketeer bent die consumentengedrag analyseert, een developer die architectuurbeslissingen neemt, of een ondernemer die investeringsscenario’s doorrekent - AoT kan het verschil maken tussen bruikbare inzichten en een warboel aan halfbakken conclusies.