Eindelijk een vaccin tegen hallucinaties

PLUS: Hoe jij het volgende Netflix-succes kan creëren, en saaie papers kan omzetten in een boeiende videopresentatie.

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

Tijdelijke systeemupdate: onze Xiang heeft haar laptop dichtgeklapt en is twee weken op vakantie (ja, ook techjournalisten hebben af en toe een digitale detox nodig). Gelukkig springt Maarten, een ervaren AI-adoptie consultant, bij als gastredacteur en zorgt dat jullie geen enkele AI-ontwikkeling missen. Veel leesplezier!

🗞️ Het belangrijkste nieuws

Anthropic test vaccin tegen AI-hallucinaties (en het werkt verrassend goed).

Je vraagt je chatbot om een boekentip en krijgt een titel die niet bestaat. Of erger: je hebt jurisprudentie nodig ter voorbereiding op een belangrijke rechtszaak, en die wordt ter plekke verzonnen. Klinkt als 2023? Helaas, ook vandaag de dag blijft hallucinatie een hardnekkig probleem. Waarom is dat eigenlijk nog steeds niet opgelost?

Wat is er aan de hand?

Ondanks de snelle ontwikkelingen in de competenties van taalmodellen, is zelfs voor de makers van de modellen nog niet precies duidelijk hoe ze werken en waarom ze soms niet goed functioneren. Een black box dus. En dat is verontrustend als je bedenkt dat deze modellen steeds meer autonoom gaan opereren en we meer verantwoordelijkheid aan ze overdragen.

Anthropic, het AI-lab achter Claude, doet veel onderzoek met als doel deze black box open te breken. Eerder schreven we al over hun onderzoek naar het morele kompas van chatbots. Hun nieuwste onderzoek gaat over trainingstechnieken om ongewenst gedrag van chatbots te voorkomen.

Hierbij wordt niet alleen gekeken naar hallucinaties, maar ook het naar de mond praten van gebruikers. Dit probleem kwam enkele maanden geleden aan het licht toen OpenAI toegaf dat ChatGPT in korte tijd steeds behaagzieker werd, waar we eerder aandacht aan besteedden. Tot slot focust het onderzoek op het risico op morele ontsporing, zoals de absurde uitspattingen van Grok 4 waar we vorige maand over schreven.

Hoe werkt het?

Het lijkt erop dat ongewenste gedragingen als hallucineren en morele ontsporing een bijproduct zijn van training op grote datasets. Behaagzucht ontstaat waarschijnlijk door onbedoelde versterking tijdens fine-tuning door interactie met gebruikers. De standaard methode om dit gedrag te voorkomen was tot nu toe om datasets beter te filteren en vervolgens duidelijke instructies te geven over het gewenste gedrag. Maar hoewel hallucinaties de afgelopen jaren zijn afgenomen, liggen ze nog altijd op de loer.

Dus bedacht Anthropic een nieuwe manier om de modellen beter te laten functioneren. Ze besloten expres ongewenste output toe te voegen in de training, waarbij ze expliciet aangaven dat dit onjuist gedrag was. Ook gaven ze aan hoe de chatbot wel moet reageren in een dergelijke situatie. Kortom, niet alleen vertellen hoe het wel moet, maar ook hoe niet. Deze gecontroleerde injecties van ongewenst gedrag (door de onderzoekers vaccinaties genoemd) leidden ertoe dat het taalmodel minder van dit gedrag ging vertonen, zonder verlies van prestaties op benchmarks.

Weirdly elegant

Over het algemeen wordt het onderzoek positief onthaald en gezien als een mooie stap in het tegengaan van ongewenste output van taalmodellen. Sai Dheeraj Gummadi, machine learning engineer bij Motorola, noemt het onderzoek groundbreaking en ziet het als een belangrijke stap in de richting van veiliger, transparanter en beter controleerbaar AI-gedrag. Hij positioneert het werk als een grote vooruitgang in het begrijpen en sturen van AI-personaliteit, iets wat voorheen grotendeels ongrijpbaar was. En Mihai Andrei van ZME Science is vooral gefascineerd door de gebruikte techniek: “Het is alsof je een kind iets leert door negatieve voorbeelden te laten zien. It’s weirdly elegant”.

Lee Chung Ming van Business Insider is kritischer. Hij geeft aan dat deze techniek niet is getest op bewuste pogingen om ongewenste output te genereren (het zogenaamde jailbreaking). Het risico op ongewenste output zou zelfs vergroot kunnen worden als gebruikers in hun prompts specifiek gaan refereren naar de inhoud van de injecties van ongewenst gedrag en dit juist gaan aanmoedigen. Lee concludeert dat de bevindingen prematuur zijn en dat de term vaccinatie te voorbarig is.

Nog altijd een black box

Is hiermee de black box opengebroken? Niet echt. We weten dat deze techniek van vaccinaties werkt, maar op het diepste niveau weten we nog steeds niet waarom het werkt. Zoals de onderzoekers zelf zeggen: “We zijn verbaasd dat zo’n simpele techniek zulke robuuste veranderingen oplevert in het gedrag van het taalmodel”.

Er zal meer onderzoek nodig zijn om de dynamiek van taalmodellen volledig te kunnen doorgronden. Een deel van de AI community (waaronder veel onderzoekers van OpenAI en DeepMind) denken zelfs dat LLMs fundamenteel ondoorgrondelijk zijn.

Waarom is dit belangrijk?

Inzichten uit dit onderzoek kunnen helpen bij het ontwikkelen van taalmodellen waar we beter op kunnen vertrouwen, die ons minder naar de mond praten en die minder geneigd zijn moreel te ontsporen. Zodat jij je dadelijk geen zorgen meer hoeft te maken over foutieve output of overdreven geslijm.

Bovendien kan het oplossen van deze kinderziektes resulteren in meer aandacht voor de nieuwe (en veel grotere) uitdagingen die ontstaan rond het verantwoord inpassen van AI tools die steeds autonomer en intelligenter worden.

Schrijf jij straks zelf je favoriete Netflix-serie?

Na een lange werkdag plof je neer op de bank: lekker een avondje Netflixen. Maar in plaats van Squid Games of Yolanthe kies je voor iets anders: je vertelt Netflix dat je zin hebt in een luchtige romantische serie die zich afspeelt in Slovenië. Je vraagt om vijf afleveringen van 50 minuten met een happy end.

Even later zit je te kijken naar de openings-scène van de eerste aflevering, die op het moment zelf volledig naar jouw wensen is gegenereerd. Als het aan Amazon ligt, is dit over een paar jaar de normaalste zaak van de wereld.

Wat is er aan de hand?

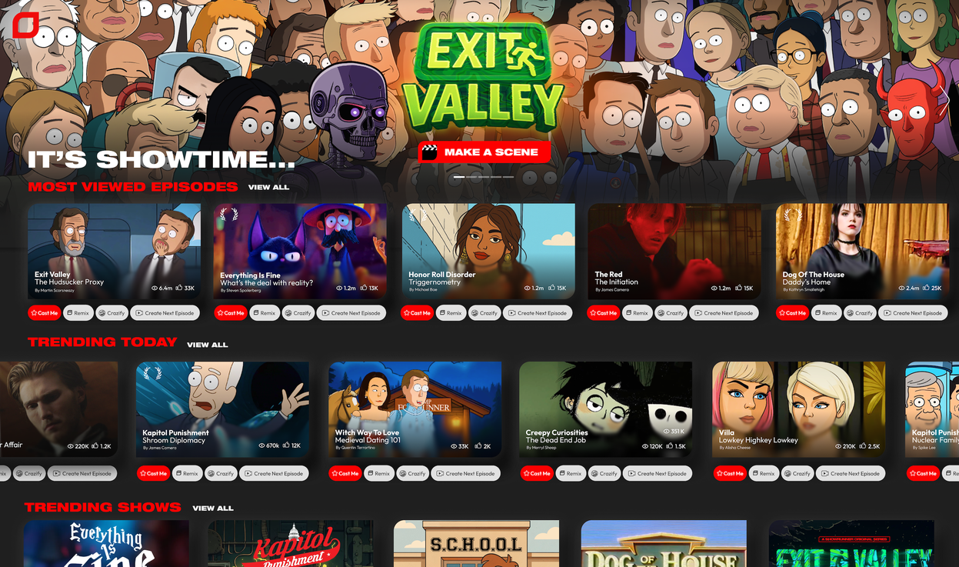

Na eerdere financiële steun aan AI-bedrijven, waaronder een miljardeninjectie in Claude, komt Amazon nu met een investering in AI start-up Fable. De timing is goed; afgelopen week lanceerde Fable haar eerste publieke tool Showrunner, die ze profileren als de ‘Netflix van AI’.

Showrunner is een platform waarop gebruikers bestaande scènes kunnen aanpassen of zelf nieuwe scènes kunnen creëren op basis van ingevoerde prompts. Het idee is dat ze op deze manier films en series kunnen maken die precies voldoen aan hun smaak en stijl.

Hoe werkt het?

Op dit moment is de alfa-versie van Showrunner gratis te gebruiken via Discord. Onze Maarten kwam er snel achter dat de mogelijkheden op dit moment nog behoorlijk beperkt zijn. Het is nog niet mogelijk om zelf iets volledig nieuws te ontwikkelen; je bent afhankelijk van twee vooraf ontwikkelde concepten met een aantal standaard personages en sets in cartoon-stijl.

In je prompt geef je vervolgens aan wat de personages gaan doen en zeggen. Dankzij de redelijk grote context window van 4000 tekens kan je de gewenste dialogen en handelingen volledig uitschrijven, maar je kan de prompt ook algemeen houden zodat je zelf verrast wordt door de uitkomst.

Voor het maken van content zal in de toekomst abonnementsgeld betaald moeten worden, maar het kijken van je eigen content of die van iemand anders blijft gratis. Het is dan ook toegestaan om je content op YouTube of andere platforms te plaatsen. En daar zijn de eerste Showrunner-clips al te vinden:

Waarom is dit belangrijk?

De CEO van Fable, Edward Saatchi, voorziet dat de impact van AI op de film-industrie veel groter wordt dan we nu denken. De creativiteit zal volgens hem verschuiven van grote productiemaatschappijen naar individuele makers. Bij Fable proberen ze daar slim op in te spelen door de grote spelers, zoals Disney, te verleiden om hun intellectual property te licenseren zodat gebruikers van Showrunner content kunnen maken met Disney-figuren.

Het is nog te vroeg om te zeggen of Showrunner de opvolger wordt van Netflix, maar het is zeker dat dergelijke apps het streaming-landschap flink gaan opschudden. Amazon, na Netflix de grootste streamingsdienst ter wereld, is in ieder geval op de toekomst voorbereid.

⚡ AI Pulse

Microsoft publiceert lijst met meest bedreigde banen door AI. Er is al veel gezegd en geschreven over de vraag in hoeverre de opkomst van AI een bedreiging vormt voor de werkgelegenheid. In een poging deze discussie meer focus te geven, heeft Microsoft onderzocht welke banen volgens hen het snelst vervangen zullen worden door AI. In de top 10 staan ‘usual suspects’ zoals vertalers, schrijvers en programmeurs, maar volgens het onderzoek moeten ook geschiedkundigen, conducteurs en radio-dj’s snel op zoek naar een nieuwe baan. Goed nieuws is er voor de baggeraars, deze beroepsgroep komt uit de bus als minst bedreigd door AI.

Eerste Europese data center van OpenAI komt in Noorwegen. Afgelopen januari stond Sam Altman van OpenAI zij aan zij met Donald Trump in het Witte Huis om het Stargate Project te lanceren. Een investering van 500 miljard dollar in data centers en andere AI-infrastructuur in de Verenigde Staten. Enkele maanden later liet OpenAI weten ook buiten de VS te gaan investeren in data centers. Dit wordt nu concreet in Europa door de aankondiging van Stargate Norway, een data center dat eind 2026 al 100,000 GPU’s moet huisvesten en vervolgens verder zal opschalen. Met het Verenigd Koninkrijk en Estland voert OpenAI gesprekken over vergelijkbare projecten.

Claude populairder dan ChatGPT bij grote bedrijven. Veel organisaties worstelen met de vraag welke AI-tool ze aanbieden aan hun medewerkers. Belangrijke afwegingen hierbij zijn competentie, veiligheid en gebruiksvriendelijkheid, die allemaal constant veranderen door de snelle ontwikkelingen bij de AI-labs. Onderzoek onder grote bedrijven in de Verenigde Staten toont aan dat de markt hierdoor erg dynamisch is. Waar OpenAI de afgelopen jaren onbetwist marktleider was, zijn ze voorbijgestreefd door Claude, dat nu 32% van de markt in handen heeft. OpenAI volgt nog wel op plek twee met 25% (een halvering ten opzichte van eind 2023), gevolgd door Google Gemini met 20%. Opvallend is dat het aandeel van open source modellen ondanks de opkomst van DeepSeek, Qwen en andere Chinese aanbieders daalt van 19% naar 13%.

Eindelijk een robot die de was doet. Misschien herinner je dit filmpje van enkele maanden terug waarin twee F.02 robots van Figure samen boodschappen uitpakken en in de koelkast leggen (check vooral ook even de bovenste comment op het filmpje). Indrukwekkend, maar wel opgenomen in de gecontroleerde lab-omgeving van Figure. Deze week dook onderstaand filmpje op, waarbij de F.02 robot ook in staat blijkt om in de echte wereld huishoudelijk werk te verrichten, inclusief toekijkende kinderen. Voorlopig alleen beschikbaar voor geselecteerde klanten in de VS en met een prijskaartje van meerdere tienduizenden euro’s, maar het is duidelijk dat huishoud-robots er nu echt aankomen.

Ontdek hoe je AI op een verantwoorde manier kunt inzetten

AI is een essentieel onderdeel geworden van organisaties. Van chatbots tot voorspellende analyses, AI transformeert de manier waarop organisaties opereren en innoveren. Organisaties moeten deze technologie omarmen om concurrerend te blijven en hun activiteiten toekomstbestendig te maken. Ontdek hoe je AI kunt inzetten op een verantwoorde en ethische manier, met aandacht voor transparantie, privacy en maatschappelijke impact.

🛠️ AI Toolkit+

Leer nooit meer hetzelfde: maak van saaie papers een boeiende videopresentatie (met narratieve voice-over!)

Deze week duiken we in een oplossing voor iedereen die weleens zuchtend door een 120-pagina tellend rapport ploetert. Wat als je gewoon je documenten kon uploaden en er een professionele videopresentatie uitrolt – compleet met AI-stem die je erdoorheen praat? Na een week intensief testen met onze favoriete AI-onderzoekstool kunnen we bevestigen: dit verandert hoe we leren en informatie delen.

Wat krijg je vandaag?

Inzicht in een AI die je documenten omtovert tot visueel aantrekkelijke videopresentaties met natuurlijke voice-over.

Onze testervaring: hoe een rapport van 71 pagina’s over AI in 2027 werd getransformeerd tot een adembenemende video van 7 minuten.

Concrete voorbeelden waarin deze technologie schittert (van studiegidsen tot teamtrainingen).

Een stap-voor-stapgids om vandaag nog je eerste AI-videopresentatie te maken.

Pro-tips voor het maken van presentaties die je collega’s of studiegenoten écht willen bekijken.