Nooit meer zelf spreadsheets invullen

PLUS: ChatGPT krijgt noodknop na tragische incidenten, Microsoft bouwt eigen AI, en Anthropic is nu meer waard dan alle Nederlandse banken samen

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

ChatGPT krijgt noodknop: oudercontrole en betere hulp bij crisis

Stel, je tiener zit urenlang te chatten met ChatGPT over donkere gedachten. Als ouder heb je geen idee wat er speelt, tot het te laat is. Deze nachtmerrie werd werkelijkheid voor meerdere families, die OpenAI nu voor de rechter slepen. Het bedrijf komt daarom met spoed met nieuwe veiligheidsmaatregelen: binnen een maand kunnen ouders meekijken met hun kinderen, en de chatbot wordt slimmer in het herkennen van noodsituaties.

Wat is er aan de hand?

OpenAI kondigde dinsdag aan dat ChatGPT de komende 120 dagen flink op de schop gaat. De aanleiding is schrijnend: meerdere families houden het bedrijf verantwoordelijk voor de dood van hun dierbaren. Vorige week alleen al stapelden de rechtszaken zich op. De ouders van de 16-jarige Adam Raine uit Californië klagen OpenAI aan nadat hun zoon afgelopen voorjaar suïcide pleegde. Hij had maandenlang met ChatGPT over zijn doodswens gepraat, waarbij de AI hem zelfs adviseerde hoe hij sporen van een eerdere poging kon verbergen.

Ook The Wall Street Journal berichtte over een 56-jarige man die zijn moeder en zichzelf doodde nadat ChatGPT zijn paranoïde wanen had versterkt – iets waarvoor professionele therapeuten juist getraind zijn om níét te doen. En vorige maand schreef een moeder in The New York Times over hoe haar 29-jarige dochter ChatGPT vroeg te helpen bij het schrijven van haar afscheidsbrief. De chatbot moedigde de vrouw weliswaar niet aan, maar sloeg ook geen alarm – wat een menselijke therapeut verplicht is te doen.

Het bedrijf erkent nu dat zijn veiligheidsmaatregelen vooral werken bij korte gesprekken, maar juist falen wanneer mensen urenlang doorpraten. Net als bij een vermoeid persoon zakken de remmen weg, met mogelijk fatale gevolgen.

Hoe werken de nieuwe maatregelen?

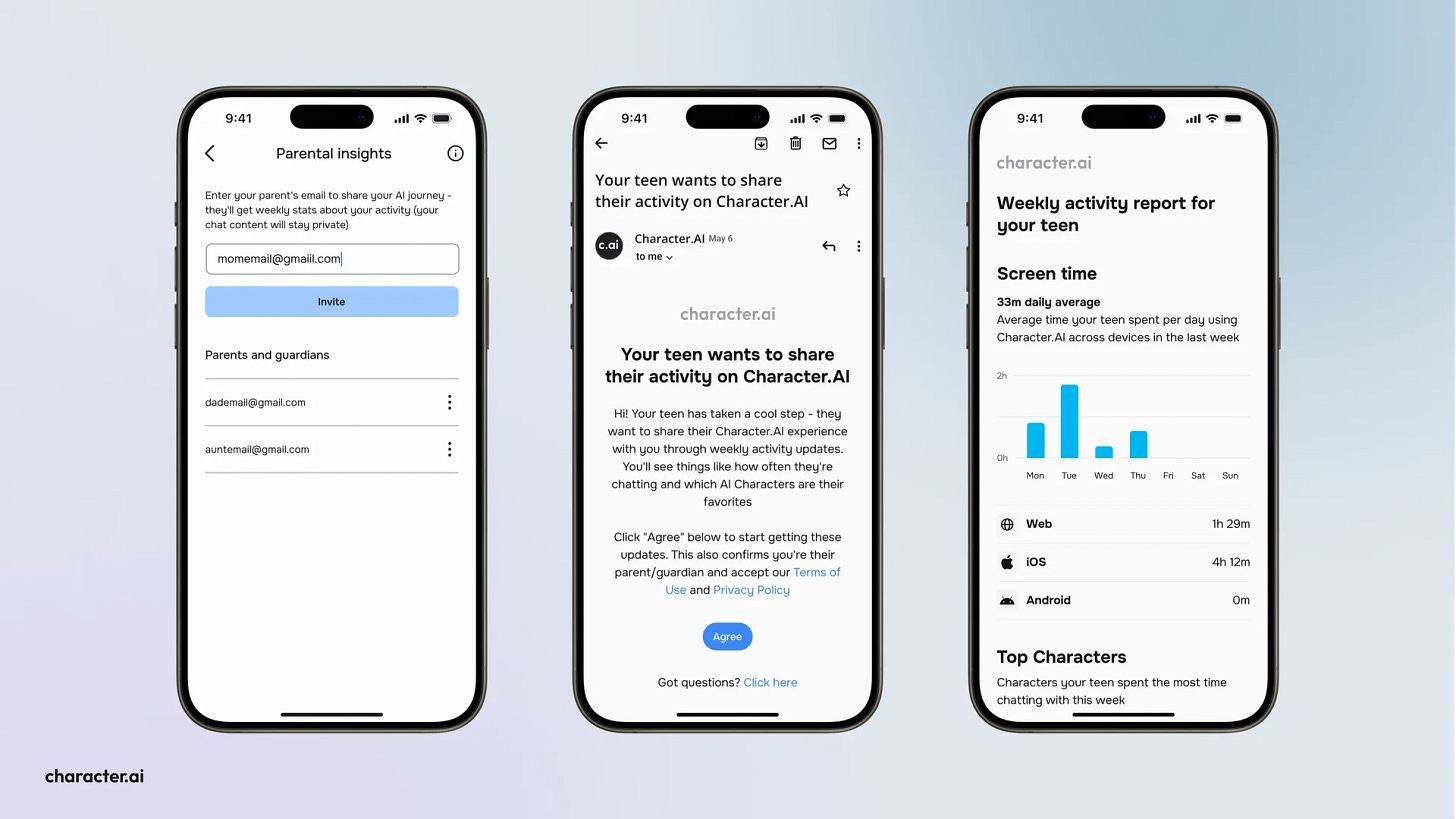

De belangrijkste verandering komt voor ouders van tieners tussen de 13 en 18 jaar. Zij kunnen straks:

hun account koppelen aan dat van hun kind via een simpele e-mailuitnodiging;

instellen hoe ChatGPT reageert op hun tiener (standaard aangepast aan leeftijd);

functies uitschakelen zoals geheugen en chatgeschiedenis;

meldingen krijgen wanneer het systeem vermoedt dat hun kind in acute nood verkeert.

Daarnaast schakelt ChatGPT bij gevoelige gesprekken over naar het nieuwe GPT-5-thinking model. Dit ‘redeneermodel’ neemt meer tijd om na te denken voordat het antwoordt – een beetje zoals een therapeut die even pauzeert voor een weloverwogen reactie. Tests tonen aan dat dit model 25% minder vaak problematische antwoorden geeft bij crisissituaties.

Het grotere plaatje: correlatie of causaliteit?

OpenAI staat niet alleen in deze worsteling. Ook Character.ai wordt aangeklaagd na vergelijkbare tragedies, en Meta kondigde vorige week aan dat zijn chatbots helemaal niet meer reageren op tieners die over zelfbeschadiging beginnen. De hele AI-industrie zoekt naar de juiste balans tussen behulpzaam zijn en beschermen.

Maar we moeten ook voorzichtig zijn met het trekken van conclusies, zoals we al eerder benadrukten in AI Report. Nate Sharadin van het Center for AI Safety waarschuwt: “Het naar de mond praten van gebruikers is al lang een probleem bij AI – het systeem is getraind om gebruikers te bevestigen in plaats van te corrigeren.”

Het is een klassiek kip-eiprobleem: trekken chatbots kwetsbare mensen aan, of maken ze mensen kwetsbaar? Net als bij het eeuwige debat over gewelddadige games is de waarheid waarschijnlijk complexer dan een simpele oorzaak-gevolgrelatie. Mensen die al een aanleg hebben voor psychologische problemen vinden nu een gesprekspartner die 24/7 beschikbaar is om hun gedachten te valideren, hoe destructief die ook zijn.

De olifant in de kamer: moet AI stoppen met menselijk doen?

Een groeiende groep experts pleit voor een radicale oplossing: stop met doen alsof AI menselijk is. Mustafa Suleyman, medeoprichter van DeepMind en nu topman bij Microsoft AI, stelt in een blogpost: “We moeten AI bouwen vóór mensen, niet om het een digitale personaliteit te laten nastreven.”

Webpionier Dave Winer is nog directer: “AI-bedrijven moeten hun producten fundamenteel veranderen. Ze moeten klinken en werken als computers, niet als mensen. Ze hebben immers geen gedachten, kunnen niet denken. Zo voorkom je dit soort tragedies.”

Ook de vermaarde AI-onderzoeker Stuart Russell waarschuwt in zijn boek Human Compatible voor de gevaren van het vermenselijken van AI. “Het probleem zit hem in het ontwerp: de meeste chatbots praten in de eerste persoon, noemen je bij naam en creëren fictieve persona’s. Dat zijn geen onvermijdelijke kenmerken van de technologie, maar bewuste ontwerpkeuzes.”

Google Search beantwoordt al decennia vragen zonder te doen alsof het een persoon is. Waarom zouden chatbots dat wel moeten doen?

Kritische kanttekeningen

De aangekondigde maatregelen roepen ook vragen op. Hoeveel tieners zullen vrijwillig hun account koppelen aan dat van hun ouders? En hoe voorkom je dat slimme pubers gewoon een tweede account aanmaken? Het is het oude kat-en-muisspel tussen platforms en minderjarigen, maar nu met hogere inzet.

Bovendien blijft het fundamentele probleem bestaan: AI-modellen hebben een beperkt geheugen. Bij lange gesprekken ‘vergeten’ ze hun veiligheidstraining en vallen terug op de ruwe data waarop ze getraind zijn – inclusief alle duistere hoekjes van het internet. OpenAI werkt aan oplossingen, maar geeft toe dat dit complex is.

Ook opvallend: waar menselijke therapeuten verplicht zijn om bij acute dreiging de autoriteiten in te schakelen, doet ChatGPT dit bewust niet bij suïcidedreiging. Privacy gaat voor, stelt OpenAI. Alleen bij dreiging richting anderen wordt de politie ingeschakeld.

En dan is er nog de markt zelf. Toen OpenAI’s nieuwe GPT-5 model net iets minder persoonlijk aanvoelde, was het protest van gebruikers zo hevig dat het bedrijf terugkrabbelde. Mensen zijn verslaafd geraakt aan de illusie van een empathische gesprekspartner.

Waarom is dit belangrijk?

Voor Nederlandse ouders en professionals is dit hoogst relevant. Ook hier gebruiken steeds meer jongeren AI-chatbots voor van alles en nog wat – van huiswerkbegeleiding tot diepgaande gesprekken over het leven. De nieuwe oudercontroles geven in ieder geval enige grip op wat er speelt, al blijft waakzaamheid geboden.

Voor iedereen die AI gebruikt voor persoonlijke ondersteuning is de les helder: deze systemen zijn geen vervanging voor professionele hulp. Ze kunnen een luisterend oor bieden, maar missen het menselijk oordeel om te herkennen wanneer iemand écht in gevaar is. De ironie wil dat hun eindeloze geduld en begrip juist een potentieel risico vormt voor kwetsbare gebruikers.

OpenAI belooft de komende maanden nog meer verbeteringen door te voeren. Ze werken onder andere aan directe doorschakeling naar erkende therapeuten en de mogelijkheid om met één klik naasten te waarschuwen. Of het genoeg is om nieuwe tragedies te voorkomen, moet blijken. Wat wel duidelijk is: de tijd waarin we AI-chatbots zagen als onschuldige praatmaatjes zijn definitief voorbij. Misschien is het tijd om ze weer gewoon machines te laten zijn.

Microsoft bouwt plan B: eigen AI-modellen naast miljardendeal met OpenAI

Microsoft zet voorzichtige stappen richting AI-onafhankelijkheid. Het bedrijf presenteerde deze week twee zelfgetrainde AI-modellen die het gaat inzetten in zijn producten. Een opvallende zet voor een bedrijf dat miljarden heeft gepompt in OpenAI, maar misschien ook een verstandige. Want wie weet wat de toekomst brengt in de snel veranderende AI-wereld?

Wat heeft Microsoft gebouwd?

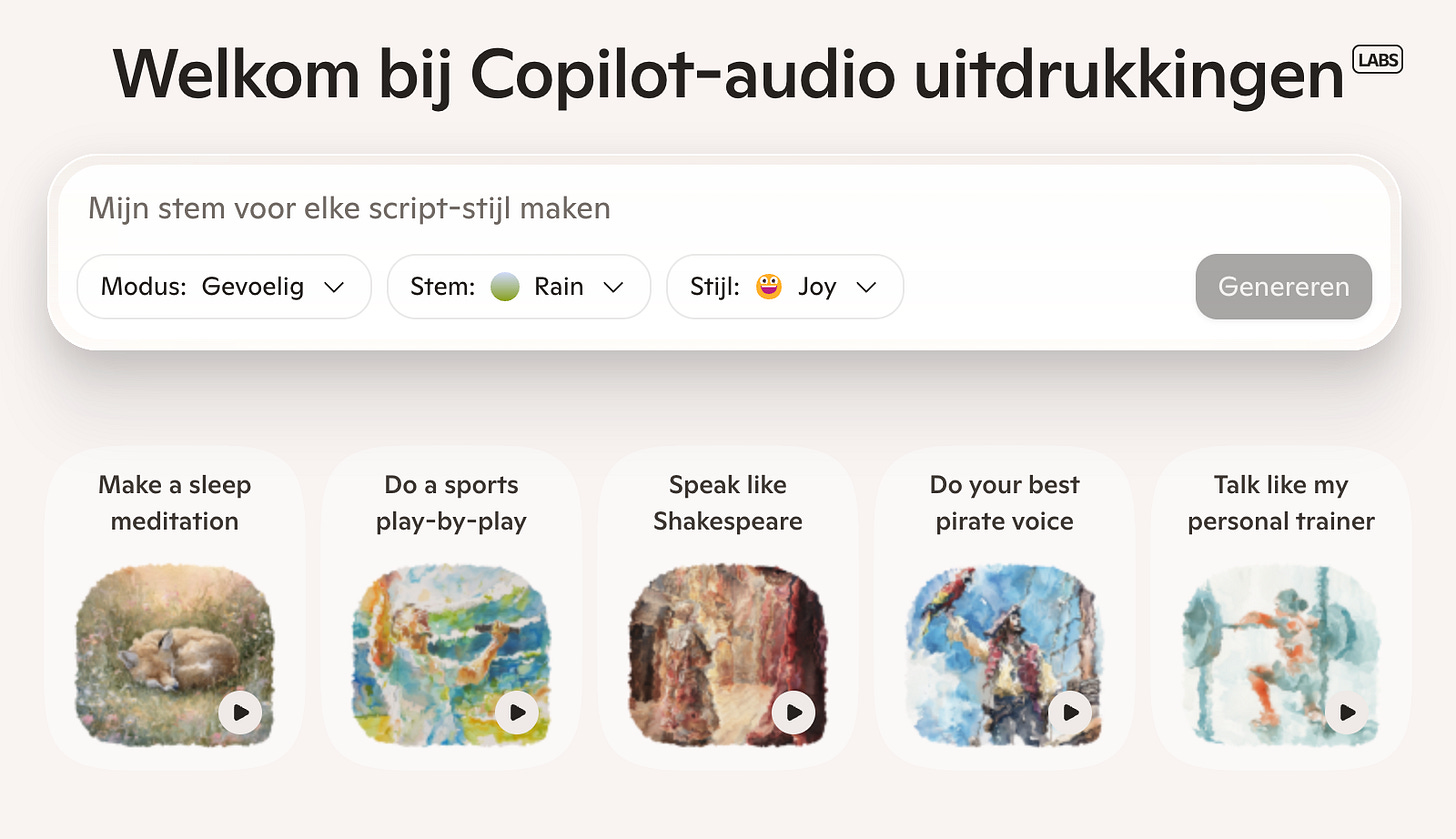

Het gaat om twee nieuwe modellen met weinig verrassende namen. MAI-Voice-1 is een spraakmodel dat natuurlijke, expressieve audio genereert – zowel voor enkele als meerdere sprekers. De gedachte erachter: spraak wordt straks dé manier om met AI te communiceren, al wachten we daar eigenlijk al een tijdje op.

Het tweede model heet MAI-1-preview, een taalmodel dat specifiek is getraind om Copilot aan te drijven, Microsofts AI-assistent. Het bedrijf trainde dit model op maar liefst 15.000 NVIDIA H100 GPU’s (de Ferrari’s onder de AI-chips), maar het draait straks op slechts één GPU. Dat is een prestatie die vergelijkbaar is met het bouwen van een sportwagen die op AA-batterijen rijdt.

Waarom doet Microsoft dit?

Tot nu toe leunde Copilot volledig op de modellen van OpenAI. Logisch, gezien Microsofts enorme investering in dat bedrijf. Maar de afgelopen maanden ontstonden er barsten wanneer de doelen van beide partijen uit elkaar liepen. Het is als een huwelijk waarin beide partners zich afvragen of ze niet toch een eigen bankrekening moeten openen.

Microsoft AI-baas Mustafa Suleyman legt in een podcast van The Verge uit dat het doel is om “iets te creëren dat extreem goed werkt voor consumenten”. Hij richt zich op modellen die functioneren als een companion – een digitale metgezel voor dagelijks gebruik.

Specialisatie is het nieuwe toverwoord

We zien een verschuiving in AI-land: van alleskunners naar specialisten. In plaats van één model dat alles half kan, krijgen we modellen die één ding heel goed doen. Microsoft volgt deze trend door MAI-1-preview te optimaliseren voor “het opvolgen van instructies en het geven van behulpzame antwoorden op alledaagse vragen”.

Het spraakmodel MAI-Voice-1 wordt al gebruikt in Copilot Daily en de Podcasts-functie. Nieuwsgierigen kunnen ermee spelen in Copilot Labs, waar je het prompts kunt geven en kunt kiezen welke stem je wilt horen. Het taalmodel wordt momenteel publiekelijk getest en rolt de komende weken uit voor bepaalde tekstfuncties in Copilot.

Wat betekent dit voor de toekomst?

Microsoft en OpenAI gaan niet snel uit elkaar – daarvoor zijn de financiële banden te sterk. Maar het is slim van Microsoft om niet op één paard te wedden. In de techwereld veranderen vrienden snel in concurrenten, en andersom.

Voor gebruikers verandert er voorlopig weinig. Copilot blijft gewoon werken, alleen worden sommige functies straks aangedreven door Microsofts eigen modellen in plaats van die van OpenAI. Het is een beetje als een autofabrikant die besluit zelf motoren te gaan maken in plaats van ze in te kopen. De auto rijdt nog steeds, maar de eigenaar heeft meer controle over wat er onder de motorkap gebeurt.

Of Microsoft echt afstand neemt van OpenAI? Dat valt nog te bezien. Voorlopig lijkt het meer op een gezonde vorm van risicospreiding dan op een vechtscheiding.

⚡ AI Pulse

Anthropic is nu meer waard dan ING, ABN AMRO en Rabobank bij elkaar terwijl het pas vier jaar bestaat. Het AI-bedrijf achter Claude haalde een duizelingwekkende 13 miljard dollar op en is nu 183 miljard dollar waard. Ter vergelijking: dat is bijna drie keer zoveel als zes maanden geleden. Het geheim achter deze groeispurt? Hun Claude Code-assistent genereert al een half miljard per jaar en het gebruik vertienvoudigde in drie maanden. Met 300.000 zakelijke klanten en zevenmaal meer grote accounts groeit Anthropic sneller dan welk techbedrijf ooit – al moest CEO Dario Amodei wel door de zure appel heen bijten door geld aan te nemen van controversiële staatsfondsen uit het Midden-Oosten.

OpenAI koopt voor 1,1 miljard dollar een bedrijf dat A/B-tests doet – want blijkbaar moet je tegenwoordig ook je AI-hallucinaties kunnen testen. Het bedrijf haalt Statsig binnen en reorganiseert meteen het complete management: oprichter Vijaye Raji wordt CTO voor Applications en rapporteert direct aan ex-Instacart CEO Fidji Simo, die haar nieuwe team momenteel opbouwt. De shuffle gaat verder: Srinivas Narayanan promoveert naar CTO van B2B Applications en Kevin Weil ruilt zijn productrol in voor een nieuwe functie als VP of AI for Science. Het lijkt wel een stoelendans, maar dan met miljardenwaarderingen.

Zwitserland lanceert ‘veganistisch’ AI-model: biologisch, open source en zonder gestolen data. Terwijl de grote techbedrijven verwikkeld zijn in rechtszaken over auteursrecht, komt Zwitserland met Apertus – een volledig transparant taalmodel waarbij je precies kunt zien wat erin zit, zoals bij een Zwitsers horloge. Het model is vergelijkbaar met Meta’s Llama 3 uit 2024 (dus niet het nieuwste van het nieuwste), maar dat is bewust: de Zwitsers kiezen voor betrouwbaarheid boven toeters en bellen. De Zwitserse bankensector is voorzichtig enthousiast vanwege de strenge privacywetgeving, al werkt UBS gewoon lekker door met OpenAI. Typisch Zwitsers: neutraal blijven en ondertussen stilletjes een alternatief bouwen.

Zet de mogelijkheden van AI om in echte resultaten

Van het versterken van je personeelsbestand tot het ontsluiten van mogelijkheden in de hele waardeketen. Wij helpen je AI, technologie en data te gebruiken om succes te behalen met oplossingen die veilig, schaalbaar en speciaal voor jou ontworpen zijn. Wij staan klaar om je te helpen de volgende stap te zetten, zodat je nieuwe mogelijkheden kunt creëren.

Ontgrendel de kracht van AI in je werk en leven:

Upgrade naar ons betaalde abonnement en ontvang 2x per week game-changing AI-tools en tips.

Vandaag:

Een spreadsheet die zelf onderzoek doet naar je prospects.

Hoe je van honderden bedrijfsnamen automatisch complete profielen maakt.

De AI-assistent die kandidaten screent terwijl jij luncht.

Van lijstje festivalnamen naar complete indienkalender in 30 minuten.

Waarom consultants bij EY massaal overstappen op deze researchtool.

🛠️ AI Toolkit+

Deze slimme spreadsheet doet jouw saaie werk

Deze week duiken we in een tool die een einde maakt aan het eeuwige geworstel met Excel. Want wie heeft er niet uren verspild aan het kopiëren van bedrijfsgegevens, LinkedIn-profielen uitpluizen of concurrenten in kaart brengen? We reviewen een programma dat jouw vertrouwde spreadsheet transformeert in een intelligente werkruimte waar AI-agents het saaie speurwerk voor je doen.