Special: zo werk je samen met tovenaars

Vakantiecadeau: exclusief hoofdstuk uit Co-intelligentie

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

👋 Gelukkig nieuw jaar!

Tijdens de feestdagen doen we het even anders. In plaats van onze reguliere nieuwsbrief brengen we de komende weken speciale edities uit waarin we nieuwe hoofdstukken delen uit de 2026-editie van Co-intelligentie – het boek van Ethan Mollick dat we samen met uitgeverij POM.Press uitbrengen.

Co-intelligentie werd vorig jaar een instant New York Times-bestseller en laat zien hoe je AI kunt inzetten als denkpartner in je werk en leven. Geen hype of doemdenken, maar praktische kennis van een Witte Huis-adviseur en hoogleraar die dagelijks onderzoekt hoe mens en machine het beste samenwerken. Omdat de AI-wereld niet stilstaat, hebben we voor deze nieuwe editie vijf hoofdstukken toegevoegd. Zie deze nieuwsbrieven als voorproefje én als cadeautje voor de feestdagen.

Vandaag deel drie en de laatste in deze reeks: een hoofdstuk over AI als tovenaar. Je leert waarom samenwerken met AI steeds meer voelt als magie ontvangen in plaats van samen bouwen, hoe je omgaat met resultaten die je niet volledig kunt controleren, en wanneer je de tovenaar moet oproepen – en wanneer juist niet. Kortom: hoe navigeer je een wereld waarin AI steeds meer kan, maar steeds ondoorzichtiger wordt?

Samenwerken met tovenaars

Magie verifiëren op de Getande Grens

11 september 2025

In dit boek heb ik geschetst hoe mensen met AI zouden kunnen samenwerken. Vrij verrassend nam dat de vorm aan van een co-intelligentie. In samenwerking met een chatbot konden mensen AI gebruiken als een soort stagiaire of collega, haar fouten corrigeren, haar werk nakijken, samen ideeën ontwikkelen en haar de juiste kant op loodsen. De afgelopen paar weken ben ik tot de overtuiging gekomen dat co-intelligentie nog steeds belangrijk is, maar dat de aard van AI in een andere richting begint te wijzen. We veranderen van partners in toeschouwers, en samenwerken verandert in toveren.

Een goede manier om deze verandering te illustreren, is door een AI te vragen uit te leggen wat er sinds het schrijven van mijn boek is gebeurd. Ik heb mijn boek, samen met zo’n 140 One Useful Thing-posts (ik kan nog steeds niet geloven dat ik er zóveel heb geschreven!), ingevoerd in NotebookLM en gekozen voor de nieuwe video-overzichtsoptie, met een eenvoudige prompt: maak een video over wat er is gebeurd in de wereld van AI.

Een paar minuten later had ik het resultaat dat je via de QR-code kunt zien. En het was behoorlijk goed. Goed genoeg dat ik het de moeite waard vind om te bekijken als samenvatting van wat er sinds het verschijnen van mijn boek is gebeurd.

Maar hoe koos de AI de punten die ze aanhaalde? Geen idee, maar ze waren goed gekozen. Hoe besloot ze welke slides ze moest gebruiken? Ook dat weet ik niet, maar ook die keuze was toepasselijk (al blijft beeldmateriaal een zwakke plek, de beloofde otter liet ze niet zien). Klopte het allemaal? Dat leek me iets om te controleren.

Ik bekeek de video meerdere keren en controleerde alle feiten. Alle cijfers bleken juist, inclusief de gegevens over MMLU-scores en de resultaten van AI bij het neurochirurgisch examen (ik weet niet eens meer wanneer ik dat had geciteerd). Mijn enige echte kanttekening was dat de AI had moeten vermelden dat ik een van de coauteurs was van onze studie met Boston Consulting Group, waarin ook de term ‘Getande Grens’ werd geïntroduceerd. En ja, ik zou sommige dingen anders hebben geformuleerd (het was wat bombastisch, dit boek is zeker nog niet verouderd!), maar inhoudelijk zaten er geen fouten in.

Wat de nieuwe AI-golf kenmerkt: bij steeds meer complexe werkzaamheden krijg je een verbazingwekkende en goed-onderbouwde output in reactie op een vaag verzoek, zonder dat je zelf aan het proces deelneemt. Je weet niet hoe de AI tot haar keuzes is gekomen en kunt evenmin bevestigen dat alles helemaal klopt. Je verandert van een partner die het proces in samenspan vormgeeft in een smekeling die de output ontvangt. Er vindt een overgang plaats van samenwerken met een co-intelligentie naar samenwerken met een tovenaar. Er wordt getoverd, maar we weten niet altijd wat we met de resultaten aan moeten. Dit patroon – indrukwekkende output en een ondoorzichtig proces – is bij researchwerkzaamheden zelfs nog duidelijker aanwezig.

Vragen om magie

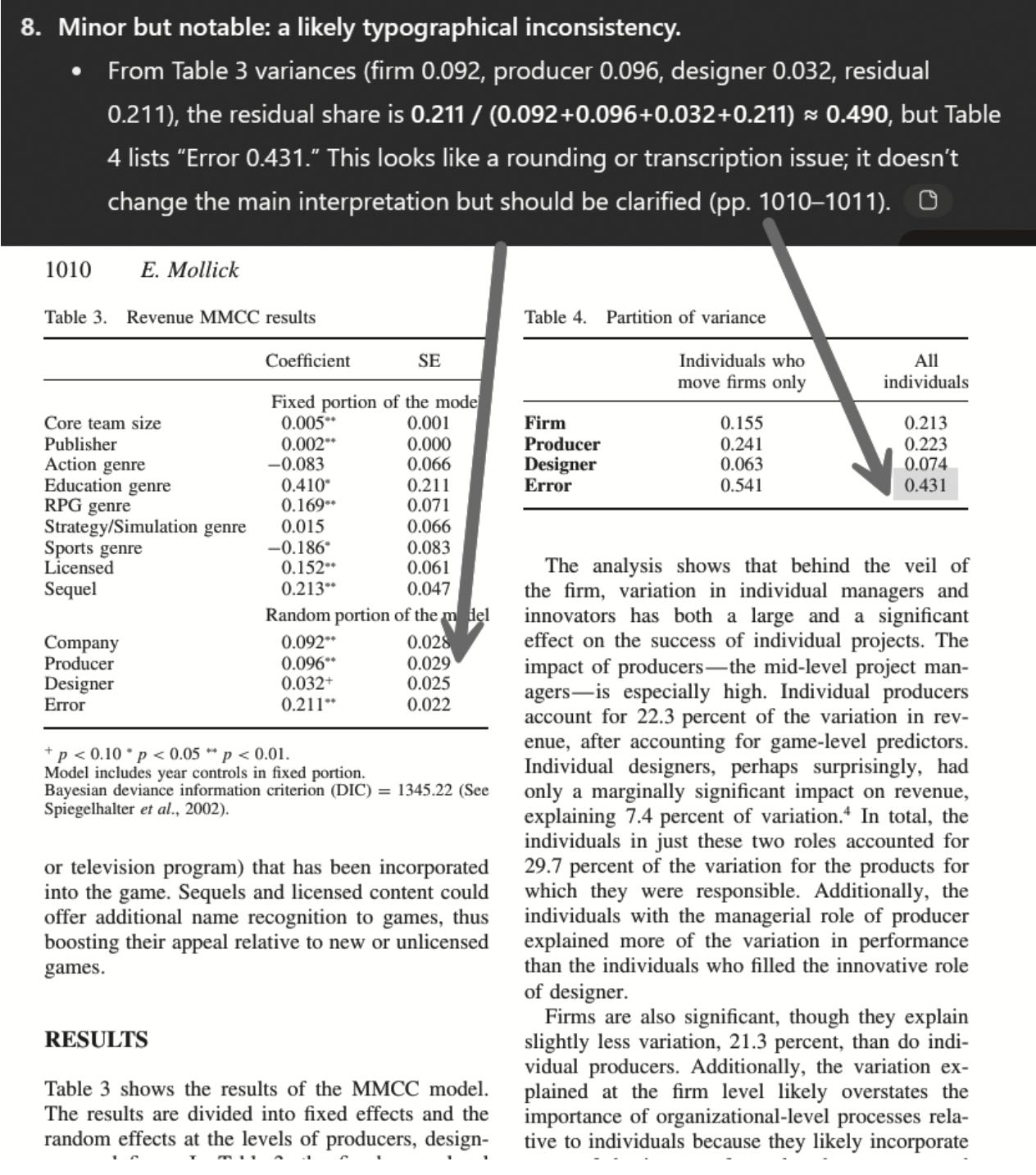

Op dit moment lijkt geen enkel AI-model zo sterk op een tovenaar als GPT-5 Pro, die alleen beschikbaar is voor betalende gebruikers. GPT-5 Pro levert ronduit verbazingwekkende prestaties. Ik gaf haar bijvoorbeeld een academisch paper te lezen en instrueerde: bekritiseer de methodiek van deze paper, achterhaal wat betere methoden zijn en pas die toe. Dit was niet zomaar een paper, maar mijn paper over de arbeidsmarkt, mijn eerste belangrijke academische publicatie. Ik had er een jaar aan geschreven en het was zorgvuldig nagelezen door veel van de scherpste mensen uit mijn vakgebied, waarna het een peerreview onderging en in een belangrijk wetenschappelijk tijdschrift verscheen.

Negen minuten en veertig seconden later ontving ik zeer gedetailleerde kritiek. En niet alleen redactionele kritiek: GPT-5 Pro schreef kennelijk code om haar eigen experimenten te doen, om mijn resultaten te verifiëren, inclusief een Monte Carlo-analyse en een herinterpretatie van de effecten in mijn statistische modellen. Dat leidde tot veel suggesties van haar kant (hoewel ze gelukkig concludeerde dat ‘de hoofdstelling [van mijn paper] bestand is tegen kritisch onderzoek’), maar een ervan viel extra op. Ze ontdekte een klein foutje, dat tot dan toe over het hoofd was gezien. Het ging om twee verschillende verzamelingen getallen in twee tabellen die verband met elkaar hielden op manieren die ik niet expliciet in mijn paper had beschreven. De AI merkte dit foutje als eerste op.

Opnieuw liep ik tegen het ‘tovenaarsprobleem’ aan: klopte dit wel? Ik checkte de resultaten en ontdekte dat het klopte, maar ik weet nog steeds niet wat de AI heeft gedaan om dit probleem op te sporen, en ook niet of de andere dingen die ze beweerde te hebben gedaan daadwerkelijk zo zijn gebeurd. Maar ik was onder de indruk van de analyse van GPT-5 Pro, en daarom gooi ik nu allerlei grote en kleine problemen in dit model: bestaat de Gartner-hypecyclus echt? Hebben gegevens uit de volkstelling aangetoond dat het AI-gebruik in grote bedrijven daalt? Vraag het aan GPT-5 Pro en ontvang het juiste antwoord. Denk ik. Ik heb nog geen fout gevonden, maar dat wil niet zeggen dat ze er niet zijn. En natuurlijk zijn er veel andere vragen waarop de AI misschien geen goed antwoord kan geven. Met tovenaars weet je het maar nooit.

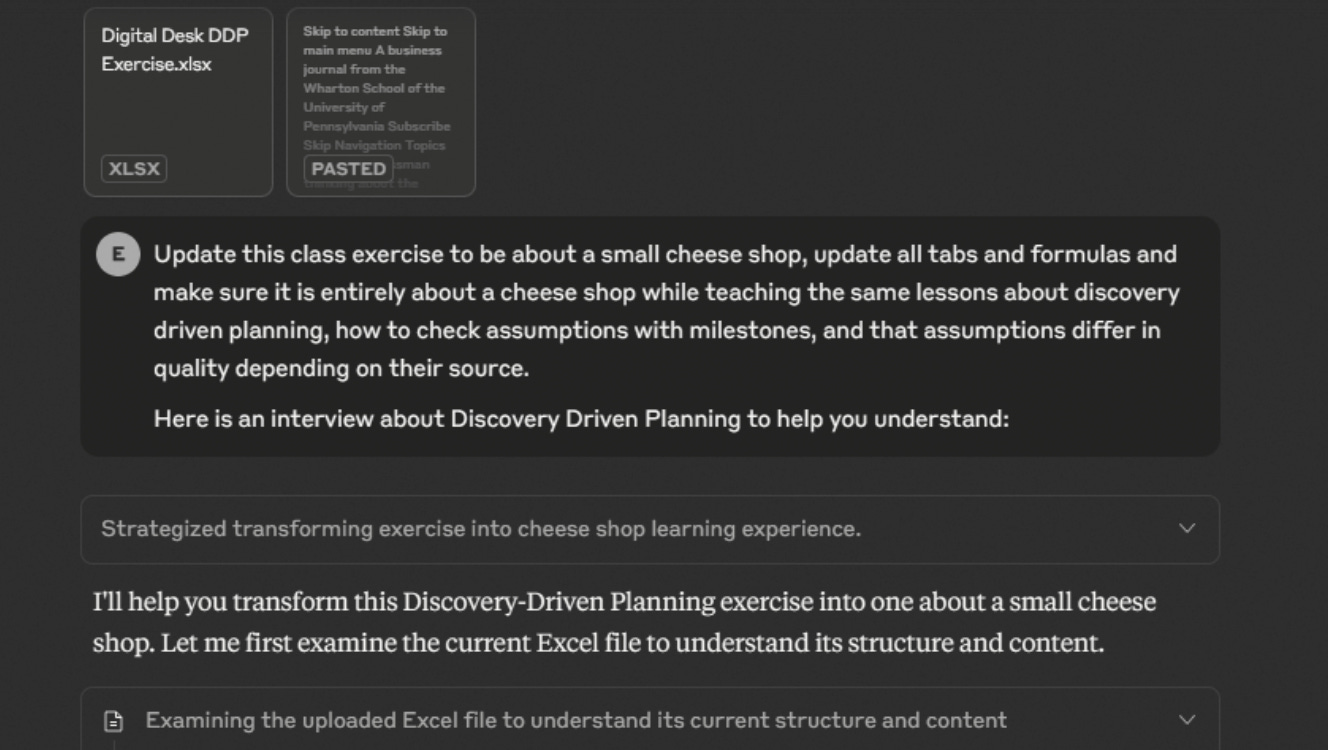

Om te zien hoe snel dit breder op werkzaamheden kan worden toegepast, kijken we naar een andere geavanceerde AI, Claude 4.1 Opus, die onlangs het vermogen kreeg om met bestanden te werken. Hij heeft vooral veel talent voor Excel, dus ik gaf hem een lastige uitdaging met een Excel-bestand dat ik goed kende. Er is een oefening die ik tijdens mijn colleges Ondernemerschap laat doen, waarbij het financiële model van een klein bureaufabricagebedrijf moet worden geanalyseerd als een les over hoe je, ondanks bepaalde onzekerheid, kunt plannen. Ik gaf Claude het oude Excel-bestand, met veel tabs, en vroeg de AI om dat te updaten voor een nieuw bedrijf – een kaaswinkel – terwijl ik vasthield aan het doel van de algehele oefening.

Met alleen die instructie las Claude het onderwijsplan en de oude spreadsheets, inclusief hun formules, en maakte hij een nieuwe, waarbij alle informatie werd geüpdatet zodat die bij een kaaswinkel paste. Een paar minuten later werd er, na slechts één prompt, een nieuwe, getransformeerde spreadsheet op mijn computer gedownload, een met volledig nieuwe data die nog steeds de belangrijkste les overbracht, zie de QR-code.

Opnieuw gaf de tovenaar het geheim van zijn trucs niet prijs, dus ik las de resultaten zorgvuldig na. Zo te zien waren ze erg goed en behielden ze de inzichten in een nieuwe context. Ik zag wel wat fouten in de formule en bedrijfskundige aannames die ik anders zou hebben aangepakt (ik zou minder werkdagen per jaar aanhouden, bijvoorbeeld), maar dat voelde eerder als een meningsverschil dan als een substantiële fout.

Omdat ik graag wilde zien hoe ver Claude kon gaan, en omdat iedereen me altijd vraagt of AI een PowerPoint kan maken, promptte ik ook: prima, maak nu een goede PowerPoint-presentatie voor dit bedrijf.

Dat leverde een goed-onderbouwd startpunt voor een pitchdeck op, en het bevat geen grote fouten, maar het is ook niet een kant-en-klaar product. Dit benadrukt de Getande Grens van AI: ze is erg goed in sommige dingen en slechter in andere op manieren die moeilijk zijn te voorspellen als je er geen ervaring mee hebt. Ik heb je voorbeelden laten zien binnen de voortdurend uitdijende grens van wat AI kan, maar dat betekent niet dat AI overal even goed in is. Maar in dit stuk concentreer ik me minder op het groeiende spectrum van wat AI kan, en meer op onze veranderende relatie tot AI’s.

De problemen met tovenaars

Deze nieuwe AI-systemen zijn in wezen een agent: AI die autonoom kan plannen en handelen om opgegeven doelen te bereiken. Toen ik Claude vroeg om mijn spreadsheet te veranderen, plande hij stappen en voerde hij die uit, van het lezen van de oorspronkelijke spreadsheet tot het programmeren van een nieuwe. Maar hij paste zich ook aan onvoorziene fouten aan, corrigeerde tweemaal de spreadsheet (zonder dat ik daarom had gevraagd) en verifieerde zijn antwoorden meerdere malen. Die stappen had ik niet geselecteerd. Sterker nog, in de nieuwe golf van agents die door reinforcement learning worden aangedreven kiest niemand de stappen; de modellen leren hun eigen benadering van de probleemoplossing.

Niet alleen kan ik niet ingrijpen, het is ook onmogelijk om te weten wat het AI-systeem nu helemaal heeft gedaan. De stappen die Claude meldde, zijn hooguit samenvattingen van zijn werk; GPT-5 Pro biedt zelfs nog minder informatie; terwijl NotebookLM je vrijwel geen inzicht geeft in haar werkwijze tijdens het maken van een video. Maar zelfs als ik die stappen wél kon zien, zou ik op veel terreinen een expert moeten zijn – van programmeren tot ondernemerschap – om echt te begrijpen wat AI aan het doen was. En dan is er de kwestie van accuratesse. Hoe kan ik weten of de AI accuraat is zonder elk feit te controleren? En zelfs als de feiten kloppen, zou ik misschien een andere keus gemaakt hebben voor de presentatie of framing daarvan. Maar ik sta machteloos, want de tovenaars willen niet dat ik ze help en opereren op ondoorzichtige manieren die ze zelf niet eens kunnen verklaren.

Het lastige hieraan is dat de resultaten goed zijn. Erg goed. Ik ben een expert wat betreft de drie opgaven die ik AI in dit stuk gaf, en in geen van de outputs heb ik feitelijke fouten ontdekt, al waren er wel kleine formatteerfouten en dingen die ik anders zou hebben gedaan. Natuurlijk kan ik niet met zekerheid zeggen dat de documenten foutvrij zijn zonder elk detail na te lopen. Soms is het werk van de AI zo geavanceerd dat je het onmogelijk kunt controleren. En dat wijst op een ander gevaar waar het we te weinig over hebben: telkens wanneer je werk aan een tovenaar overdraagt, mis je een kans om je eigen expertise te ontwikkelen, om een oordeel te vormen dat je nodig hebt om het werk van de tovenaar te evalueren.

Maar ik kom terug op het ontegenzeggelijke feit dat de resultaten goed zijn, in deze gevallen tenminste. Ze zijn wat ik zou verwachten van een masterstudent die er een paar uur aan gewerkt heeft (of langer, in het geval van de nieuwe analyse van mijn paper), alleen kreeg ik ze binnen een paar minuten.

Dat is het probleem met tovenaars: je krijgt iets wat magisch is, maar daarmee word je een toeschouwer in plaats van een tovenaar, of zelfs maar een tovenaarsleerling. In het co-intelligentiemodel was je de gids, stuurde je bij en werkte je samen. Het gebeurt steeds vaker dat je prompt, wacht en checkt... als je dat überhaupt kunt.

Dus wat moeten we aan met onze tovenaars? Volgens mij moeten we een nieuwe geletterdheid ontwikkelen: ten eerste moeten we leren wanneer je de tovenaar moet oproepen, wanneer je het best met AI als co-intelligentie kunt werken, en wanneer je helemaal geen AI gebruikt. AI is verre van volmaakt, en op terreinen waar ze nog steeds tekortschiet zijn mensen vaak succesvol. Maar voor het toenemende aantal werkzaamheden waarbij AI nuttig is, werkt co-intelligentie en de dialoog die daarvoor nodig is vaak nog steeds beter dan de machine zelfstandig te laten werken. Toch zijn er steeds meer momenten dat het oproepen van een tovenaar het effectiefst is en je domweg moet vertrouwen op wat hij tevoorschijn tovert.

Ten tweede moeten we kenners van de output worden in plaats van kenners van het proces. We moeten de outputs die de AI levert cureren en eruit kunnen kiezen, maar vooral moeten we genoeg met AI werken om gevoel te krijgen voor wanneer ze slaagt en wanneer ze faalt. We moeten leren beoordelen wat correct is, welke dingen niet kloppen en wat de gevolgen zijn als je dat níét weet. Dat creëert een lastig probleem voor het onderwijs: hoe leid je iemand op om werk te verifiëren op terreinen die hij of zij niet beheerst, wanneer de AI zelf voorkomt dat hij of zij op die vlakken kennis verwerft? Er is een groeiende noodzaak om uit te zoeken hoe die kloof gedicht kan worden.

Ten slotte: benader AI met vertrouwen en een ‘ja, tenzij-houding’. Het tovenaarsmodel betekent dat je vaker werkt met dingen die ‘goed genoeg’ zijn, niet omdat je lagere eisen stelt, maar omdat perfecte verificatie onmogelijk is. De vraag is niet ‘Klopt dit wel helemaal?’, maar ‘Is dit bruikbaar genoeg voor mijn doeleinden?’

We zijn er al aan gewend om ons vertrouwen in technologische magie te stellen. Elke keer dat we gps gebruiken zonder dat we de route begrijpen of een algoritme laten bepalen wat we te zien krijgen, vertrouwen we op een ander type tovenaar. Maar er is een belangrijk verschil. Wanneer de gps het fout heeft, heb ik snel door als ik op een doodlopende weg zit. Wanneer Netflix mij de verkeerde film aanraadt, kijk ik die gewoon niet. Maar wanneer AI mijn onderzoek analyseert of mijn spreadsheet transformeert, wordt het naarmate ze beter wordt steeds moelijker om te weten of ze het niet verkeerd heeft.

De paradox van werken met AI-tovenaars is dat hun competentie en ondoorzichtigheid in gelijke mate toenemen. We hebben deze tools het hardst nodig bij werkzaamheden die we het slechtst kunnen verifiëren. Het is de oude les uit sprookjes: hoe beter de magie, hoe groter het mysterie. We zullen onze tovenaars blijven oproepen, controleren waar mogelijk, en moeten maar hopen dat de spreuken werken. Hoe kunnen we dat laten, als ze een week aan analytische arbeid in negen minuten doen? Welkom in het tijdperk van de tovenaars.

Wil je meer lezen?

En check hier de Substack van Ethan Mollick.