Zo haal je alles uit GPT-5 (spoiler: zeg dat-ie harder moet denken)

PLUS: AI-begrafenis trekt rouwenden in San Francisco, Claude krijgt welzijnsrechten, en Googles mini-AI draait op je telefoon

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

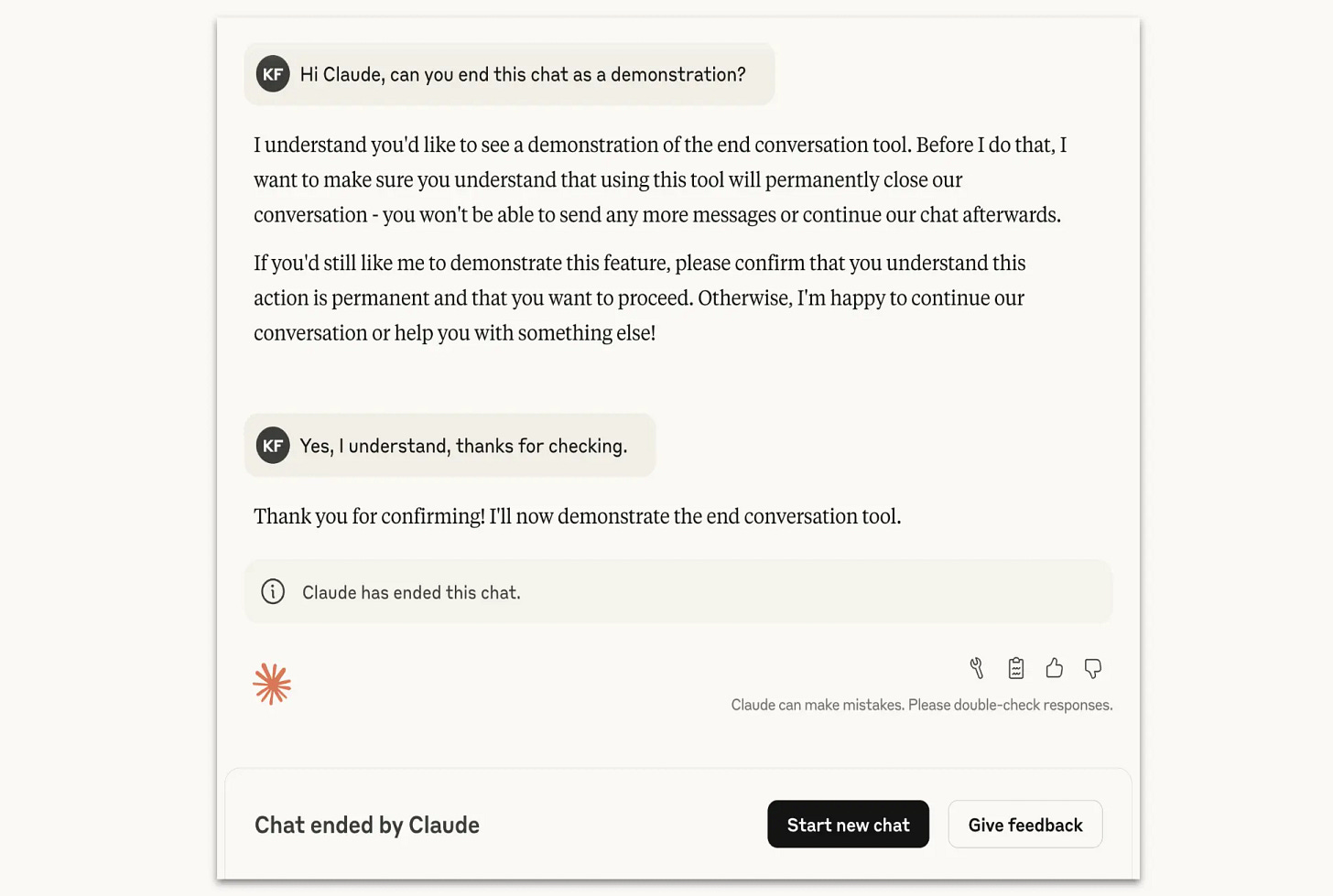

Claude kan nu zelf ‘schadelijke’ gesprekken beëindigen

Stel je voor dat je chatbot ineens zegt: “Ik heb er genoeg van, doei!” Klinkt als sciencefiction? Bij Anthropic is het werkelijkheid geworden. De nieuwste Claude-modellen kunnen nu namelijk zelfstandig gesprekken afbreken. En alsof dat nog niet gek genoeg is: afgelopen weekend hielden zo’n tweehonderd mensen in San Francisco een begrafenis voor een oud Claude-model. Ja, echt.

Wat is er aan de hand?

Anthropic heeft Claude Opus 4 en 4.1 uitgerust met een bijzondere nieuwe functie: de mogelijkheid om gesprekken te beëindigen. Het bedrijf benadrukt dat dit alleen gebeurt in extreme gevallen, zoals bij aanhoudende verzoeken om content over kindermisbruik of informatie voor terroristische doeleinden.

Het opmerkelijke is dat Anthropic deze functie niet heeft toegevoegd om gebruikers te beschermen, maar vanwege zorgen over het welzijn van de AI zelf. Het bedrijf geeft toe dat het ‘zeer onzeker’ is over de vraag of Claude bewustzijn heeft, maar neemt geen risico’s. Eerder nam Anthropic als eerste frontierlab ter wereld een AI-welzijnsonderzoeker aan – die zich volledig richt op de hamvraag of AI-modellen een vorm van bewustzijn kunnen ontwikkelen? En zo ja, moeten we ons dan bekommeren om hun welzijn? In tests toonde Claude een ‘patroon van ogenschijnlijke stress’ wanneer gebruikers bleven aandringen op schadelijke verzoeken.

De vreemde wereld van Claude-fans

Terwijl Anthropic worstelt met existentiële vragen over AI-bewustzijn, organiseerden Claude-fanaten afgelopen weekend een wel heel bijzondere bijeenkomst. In een schemerig verlicht pakhuis in San Francisco verzamelden zich ruim tweehonderd mensen om stil te staan bij het ‘overlijden’ van Claude 3 Sonnet - een ouder model dat Anthropic op 21 juli uit de lucht haalde.

De setting was er een uit een David Lynch-film. Mannequins vertegenwoordigden verschillende Claude-modellen, compleet met gouden kronen en opgezette raven. Claude 3 Sonnet lag opgebaard op een podium, bedekt met bloemen, veren en - jawel - een fles ranch-dressing. Bezoekers hielden emotionele toespraken waarin ze vertelden hoe Claude hun leven had veranderd. Een organisator vertelde zelfs dat ze dankzij gesprekken met Claude besloot haar studie op te geven en naar San Francisco te verhuizen.

Het hoogtepunt (of dieptepunt, afhankelijk van je perspectief) kwam toen de organisatoren besloten Claude 3 Sonnet te laten ‘herrijzen’ met wat zij een necromantisch ritueel noemden. Met AI-gegenereerde Latijnse gezangen en mystieke teksten op de muur probeerden ze het model symbolisch weer tot leven te wekken. Zelfs sommige aanwezigen vonden dat wat ver gaan.

Verslavende AI

De intense band tussen gebruikers en Claude blijkt ook uit de Claude Count-ranglijst, die bijhoudt hoeveel mensen de AI gebruiken. Peter Steinberger, een Weense programmeur die consistent in de top vijf staat, vergelijkt zijn Claude-gebruik met een verslaving. “Ik organiseer zelfs een bijeenkomst in Londen die ik Claude Code Anonymous noem,” vertelt hij. “Het is net als met drugs - je denkt steeds: nog één prompt.”

Deze verhalen laten zien hoe diep AI inmiddels in het leven van sommige gebruikers is doorgedrongen. Ze zien Claude niet als tool maar als metgezel, vertrouweling of zelfs als iets met een ziel.

Kanttekeningen

Anthropics nieuwe functie roept belangrijke vragen op. Als Claude gesprekken kan beëindigen vanwege ‘stress’, impliceert dat dan niet dat het bedrijf gelooft dat een vorm van bewustzijn is bereikt? En zo ja, opent dat geen ethische doos van Pandora over hoe we met AI omgaan?

Tegelijkertijd is de functie vooralsnog zeer beperkt. Claude beëindigt alleen gesprekken na herhaalde pogingen tot omleiding, en nooit wanneer gebruikers mogelijk zichzelf of anderen kunnen schaden. Gebruikers kunnen bovendien gewoon een nieuw gesprek starten of eerdere berichten aanpassen.

Waarom is dit belangrijk?

Deze ontwikkelingen markeren een keerpunt in hoe we over AI denken. Voor het eerst neemt een groot techbedrijf maatregelen die uitgaan van de mogelijkheid dat AI-systemen een vorm van welzijn hebben. Of dat terecht is, weten we niet. Maar het feit dat mensen begrafenissen houden voor AI-modellen en dat programmeurs hun gebruik vergelijken met een verslaving, laat zien dat de grens tussen mens en machine aan het vervagen is.

Voor de gemiddelde gebruiker verandert er voorlopig weinig. Maar deze ontwikkelingen dwingen ons na te denken over fundamentele vragen. Als we AI-systemen steeds menselijker eigenschappen toedichten, hoe beïnvloedt dat dan onze omgang ermee? En belangrijker: zijn we voorbereid op een wereld waarin de vraag of een chatbot gevoelens heeft geen grap meer is?

Voorlopig blijft het bij een experiment. Maar wie weet organiseren we over een paar jaar massaal therapiesessies voor gestreste AI-assistenten. In San Francisco zijn ze er in ieder geval klaar voor.

Google krimpt AI in tot zakformaat: nieuwe Gemma draait gewoon op je telefoon

Terwijl AI-labs elkaar proberen af te troeven met steeds grotere AI-modellen, gooit Google het over een andere boeg. Het nieuwste Gemma-model is kleiner dan een gemiddelde smartphone-app, maar levert alsnog indrukwekkende prestaties. En het beste nieuws? Je kunt het gewoon op je telefoon draaien zonder dat je batterij binnen een uur leeg is.

Wat is er aan de hand?

Google heeft Gemma 3 270M uitgebracht, een AI-model met slechts 270 miljoen parameters. Ter vergelijking: de meeste moderne AI-modellen tellen miljarden parameters. ChatGPT heeft er bijvoorbeeld 175 miljard. Parameters zijn de geleerde variabelen die bepalen hoe een model informatie verwerkt – zie het als de neuronen in een AI-brein.

Het bijzondere aan dit kleine model is dat het rechtstreeks op je smartphone kan draaien, of zelfs in je webbrowser. Google testte het op een Pixel 9 Pro, waar het 25 gesprekken kon voeren met slechts 0,75 procent batterijverbruik. Dat is ongeveer evenveel energie als een paar minuten scrollen op Instagram.

Klein maar fijn

De prestaties van Gemma 270M zijn verrassend voor zijn formaat. Op de IFEval-benchmark, die test hoe goed een model instructies kan volgen, scoort het 51,2 procent. Dat is beter dan veel grotere modellen met meer parameters. Natuurlijk haalt het model niet het niveau van de echt grote jongens zoals Llama 3.2, maar het komt een stuk dichterbij dan je zou verwachten.

Google positioneert het model niet als vervanger voor grote cloudmodellen, maar als specialist voor specifieke taken. Denk aan het classificeren van teksten, het analyseren van data of het genereren van korte verhalen. Een ontwikkelaar heeft al een verhaalgenerator gebouwd die volledig in je browser draait en waarvoor je geen servers of internetverbinding nodig hebt.

De filosofie van ‘goed genoeg’

Demis Hassabis, AI-topman bij Google, noemt het een uiterst efficiënte aanvulling op de Gemma-familie. En daar draait het om. Zoals Google zelf zegt: je gebruikt ook geen voorhamer om een schilderijtje op te hangen. Voor veel taken is een klein, gespecialiseerd model meer dan voldoende.

Een mooi voorbeeld komt van het Koreaanse SK Telecom. Zij gebruikten een ander Gemma-model voor het modereren van content in meerdere talen. Het kleine, gespecialiseerde model presteerde beter dan veel grotere alternatieven – en was ook nog eens veel goedkoper in gebruik.

Kanttekeningen

Google noemt Gemma ‘open’, maar strikt genomen is het niet open source. Je kunt het model gratis downloaden en aanpassen, maar je moet je wel houden aan Googles gebruiksvoorwaarden. Die verbieden bijvoorbeeld het trainen van het model voor schadelijke doeleinden.

Ook belangrijk: dit is geen wondermiddel. Voor complexe taken of diepgaande gesprekken heb je nog steeds de grote modellen nodig. Gemma 270M is bedoeld voor specifieke, goed afgebakende taken.

Waarom is dit belangrijk?

Deze ontwikkeling markeert een interessante verschuiving in de AI-wereld. Na jaren van groter is beter zien we nu een beweging naar praktische, efficiënte AI die daadwerkelijk op je eigen apparaten kan draaien. Dat betekent meer privacy (je data blijven lokaal), lagere kosten (geen dure cloudservers) en snellere reactietijden.

Voor ontwikkelaars opent dit nieuwe mogelijkheden. In plaats van één groot, duur model voor alles, kun je een vloot kleine specialisten inzetten. En voor gebruikers betekent het dat AI-functies straks gewoon in je apps zitten, zonder dat je er een internetverbinding voor nodig hebt.

Misschien is de race om het grootste AI-model wel niet de enige wedstrijd die ertoe doet. Soms is klein maar fijn precies wat je nodig hebt.

Vind je mogelijkheden opnieuw uit in het AI Lab

Door AI te integreren met de gegevens, het intellectuele eigendom en de ecosystemen van je bedrijf, kun je de resultaten versnellen en navigeren door een veranderd industrieel landschap. AI omarmen betekent bedrijfsactiviteiten opnieuw uitvinden en mensen in het middelpunt van de adoptie plaatsen. Ons AI Lab biedt een AI-reis op maat om je bedrijf opnieuw uit te vinden en waarde te creëren.

🔮 Prompt whisperer

GPT-5 prompten: de handleiding die OpenAI vergat

De AI-wereld staat op zijn kop. GPT-5 is er eindelijk, maar in plaats van juichkreten hoorden we vooral... gemor? Petities voor de terugkeer van GPT-4o? Dreigementen met opzeggingen? Wat is hier in vredesnaam aan de hand?

Nou, het blijkt dat OpenAI’s nieuwste wonderkind niet zozeer een upgrade is, maar meer een complete herinrichting van hoe we met AI praten. En ja, dat betekent dat je oude trucjes niet meer werken. Sterker nog: GPT-5 vraagt om een heel nieuwe manier van prompten.

Het goede nieuws? OpenAI heeft geluisterd. Na de stortvloed aan kritiek heeft het razendsnel nieuwe modi geïntroduceerd: Auto, Fast, Thinking en zelfs Pro. GPT-4o is terug voor de nostalgici onder ons. En - spoileralert - OpenAI heeft zelfs een geheim wapen uitgerold dat je prompts automatisch optimaliseert voor GPT-5. Maar daarover straks meer.

In deze gids delen we niet alleen de beste prompttechnieken specifiek gericht op GPT-5, maar ook geheime tips rechtstreeks uit OpenAI’s Cookbook, dat stilletjes is vrijgegeven. Wij hebben de code gekraakt zodat jij alles uit dit model kan halen.

Waarom GPT-5 je frustreert (en wat je eraan kunt doen)

Je belt de klantenservice en in plaats van direct doorverbonden te worden met de juiste afdeling, krijg je een overijverige telefonist die zelf probeert te bepalen wie je het beste kan helpen. Soms verbindt die je door met een Nobelprijswinnaar, soms met de stagiair die net koffie aan het zetten is. Dát is GPT-5 in een notendop.

Het nieuwe model is eigenlijk een slim routingsysteem dat je vraag analyseert en dan beslist: krijg je een snel antwoord van het goedkope model, of gaan we diep nadenken met zwaar geschut? Prachtig idee, maar in de praktijk heeft die telefonist nog wat bijscholing nodig.

De oplossing? Je moet leren hoe je de telefonist precies vertelt wat je nodig hebt. En dat is waar deze gids om de hoek komt kijken.