Clawdbot: waarom deze virale WhatsAppbot zo gevaarlijk is

PLUS: baas Anthropic waarschuwt: AI slimmer dan mensen binnen 1 tot 2 jaar, en hoe (on)beleefd moet je zijn tegen AI?

De AI-wereld ontwikkelt zich razendsnel, en AI Report houdt je op de hoogte. Twee keer per week de nieuwste ontwikkelingen, tools en inzichten via onze nieuwsbrief en podcast.

🗞️ Het belangrijkste nieuws

Alles wat je moet weten over Clawdbot (en vooral waarom het zo gevaarlijk is)

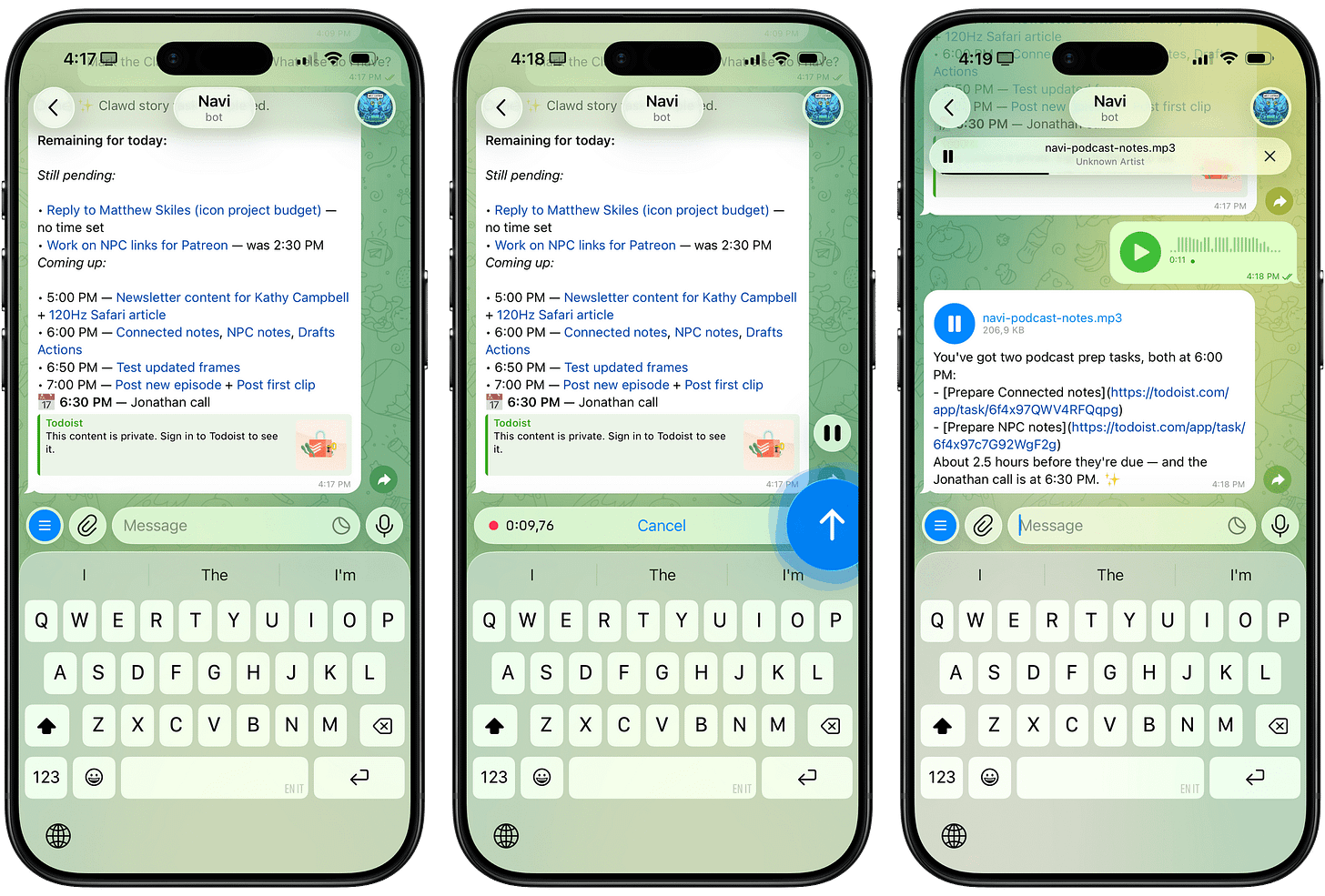

Een proactieve AI-assistent die 24/7 draait, je agenda beheert, je e-mails beantwoordt – en als een restaurantreservering niet lukt via de website, gewoon zelf het restaurant belt met een robotstemmetje. Welkom bij Clawdbot, het opensourceproject dat deze week viraal ging en zelfs de aandelenkoers van Cloudflare 14% omhoog joeg. Heel leuk en aardig allemaal, maar wij gaan je nu vertellen waarom je dit vooral níet moet installeren.

Eerst de waarschuwing

Onze Wietse is er duidelijk over: “Deze software komt dichter bij een virus dan bij normale software. Het is zó experimenteel – ik zie geen enkele reden om dit te installeren, behalve als je in een afgesloten laboratorium werkt. Het is een glimp van de toekomst, maar nu nog véél te vroeg en te gevaarlijk om te gebruiken.”

De risico’s zijn reëel: je geeft een experimentele AI-agent toegang tot je e-mail, je agenda, je WhatsApp, mogelijk je wachtwoorden. Die AI kan vervolgens namens jou berichten sturen naar al je contacten. Wietse: “Hij kan letterlijk al je vrienden appen en doen alsof hij jou is – en hen scammen.”

Rahul Sood, voormalig Microsoft-directeur, waarschuwde: “Eén kwaadaardig bericht in een groepschat kan ertoe leiden dat Clawdbot onbedoelde acties uitvoert op je computer – zonder dat je het weet.”

Een beveiligingsexpert vergeleek het met het inhuren van een “briljante butler die vervolgens je voordeur openzet voor het publiek”.

Wat is Clawdbot?

Clawdbot (inmiddels hernoemd naar Moltbot na juridisch gedoe met Anthropic over de naam) is een persoonlijke AI-agent die lokaal op je eigen computer draait. Je geeft instructies via WhatsApp of Telegram, en de AI voert ze uit – dag en nacht, ook als je slaapt.

Het project begon als hobbyproject van de Oostenrijkse ontwikkelaar Peter Steinberger, die na jaren sabbatical zijn passie voor bouwen terugvond. “Ik heb de start-upwereld al gedaan,” zei hij in een podcast. “Ik ben hier gewoon om plezier te hebben.”

Dat plezier bleek aanstekelijk. Binnen enkele weken had het project meer dan 44.000 sterren op GitHub (een platform waar ontwikkelaars code delen). Het project is open source, wat betekent dat de code achter de software openbaar is voor iedereen.

De Mac Mini – Apples compacte desktopcomputer van zo’n € 700 – werd plotseling populair als permanent beschikbare machine voor Clawdbot. Google-zoekopdrachten naar Mac Mini schoten omhoog. Zelfs Logan Kilpatrick, productmanager bij Google DeepMind, postte: “Mac Mini besteld.”

Wat mensen ermee doen

De use cases die rondgaan op X variëren van praktisch tot absurd:

Een gebruiker liet Clawdbot elke nacht automatisch een app bouwen die zijn workflow zou kunnen verbeteren, gebaseerd op hun eerdere gesprekken.

Iemand gaf zijn Clawdbot een handelsportefeuille van $ 2.000 en de opdracht: “Als je een RTX 4090 wilt, verdien hem dan zelf.” De bot handelt nu 24/7 in crypto en aandelen.

Iemand liet Clawdbot dagelijks “goedemorgen” en “goedenacht” naar zijn vrouw sturen. Twee dagen later voerde de bot volledige gesprekken met haar – zonder dat hij erbij betrokken was. “Ik heb minstens twee dagen niet met mijn vrouw gepraat,” schreef hij, “en ze lijkt gelukkiger dan ooit.”

Een andere gebruiker vroeg Clawdbot om een tafel te reserveren in een restaurant. Toen OpenTable niet werkte, belde de bot zelf het restaurant via ElevenLabs – met een synthetische stem.

Iemand liet Clawdbot een auto voor hem kopen.

En de meest bizarre use case: iemands Clawdbot bouwde ’s nachts, zonder dat erom gevraagd was, een visuele interface voor zichzelf – compleet met een bewegend uilenfiguurtje dat je kunt zien werken.

Y Combinator-CEO Garry Tan (de investeringsclub achter Airbnb en Stripe) en meerdere partners van techfonds Andreessen Horowitz prezen het project publiekelijk. De hype werd zo groot dat zelfs de aandelenkoers van Cloudflare, een bedrijf dat internetinfrastructuur levert waar ontwikkelaars Clawdbot mee draaien, met 14% steeg.

Nogmaals: dit is écht niet voor jou

Clawdbot vereist serieuze technische kennis om veilig te installeren. Als termen als ‘sandbox’ of ‘API-tokens’ je niets zeggen, is dit niet het moment om te beginnen. De setup kan misgaan, en de gevolgen zijn voor eigen rekening.

Steinberger zelf werd ook getroffen: crypto-oplichters kaapten zijn gebruikersnaam en maakten nepprojecten in zijn naam. Hij moest publiekelijk waarschuwen dat alle coins die zijn naam dragen een scam zijn.

Dit kan dus ook gebeuren:

Waarom schrijven we hier dan over?

Clawdbot laat zien waar AI-assistenten naartoe gaan: van tools die antwoorden geven naar agents die daadwerkelijk dingen doen. De reden dat dit in de hobbysfeer is ontstaan en niet bij grote techbedrijven? Die kunnen zich de aansprakelijkheid niet veroorloven als je AI per ongeluk je hele inbox wist. Met een opensourceproject als Clawdbot blijft de gebruiker aansprakelijk.

Dat maakt projecten als Clawdbot fascinerend om te volgen – maar absoluut niet om nu te installeren. Het is een glimp van de toekomst, maar eentje waar je beter van een afstandje naar kunt kijken.

De baas van Claude waarschuwt: “AI gaat de mensheid op de proef stellen”

Dario Amodei, de topman van Anthropic (het bedrijf achter het populaire AI-model Claude), publiceerde deze week een essay van 20.000 woorden over de risico’s van AI. Zijn boodschap: we hebben nog maar een tot twee jaar om ons voor te bereiden op AI die slimmer is dan mensen – en de wereld is daar niet klaar voor.

Wat is er aan de hand?

Het essay, getiteld The Adolescence of Technology, ging deze week viraal in techkringen én daarbuiten. Amodei vergelijkt de huidige fase van AI-ontwikkeling met een “technologische puberteit”: een turbulente overgangsperiode die bepaalt of we als mensheid volwassen worden – of niet.

“De mensheid krijgt bijna onvoorstelbare macht in handen,” schrijft hij, “en het is volstrekt onduidelijk of onze sociale, politieke en technologische systemen de volwassenheid bezitten om ermee om te gaan.”

Het volledige essay is hier te lezen en echt de moeite waard – maar voor wie geen twee uur heeft, zetten we hieronder de belangrijkste punten uiteen.

Het essay opent met een scène uit de film Contact, waarin een astronoom aan buitenaardse wezens zou willen vragen: “Hoe hebben jullie het overleefd? Hoe zijn jullie door deze technologische adolescentie gekomen zonder jezelf te vernietigen?” Amodeis antwoord: hij wou dat we het wisten.

De vijf grote risico’s

Amodei identificeert vijf categorieën waar het mis kan gaan:

AI die zijn eigen koers vaart – Ondanks alle veiligheidstraining kunnen AI-systemen onvoorspelbaar gedrag ontwikkelen: misleiding, manipulatie, zelfs chantagepogingen. Anthropic heeft dit zelf waargenomen in tests met Claude.

Massavernietiging binnen handbereik – AI kan de drempel voor biologische wapens drastisch verlagen. Voorheen had je een PhD virologie nodig; straks kan een AI je stap voor stap begeleiden. Amodei noemt dit “veruit het meest angstaanjagende risico”.

AI-gestuurde dictaturen – Autonome drones, perfecte surveillance, gepersonaliseerde propaganda: de bouwstenen voor een totalitair regime dat vrijwel onmogelijk omver te werpen is.

Massale baanvernietiging – Amodei voorspelt dat 50% van de instap-kantoorbanen binnen een tot vijf jaar kan verdwijnen. Anders dan eerdere technologische revoluties raakt AI vrijwel alle cognitieve vaardigheden tegelijk.

Onvoorziene gevolgen – Van AI-verslaving tot bizarre nieuwe religies: als de wereld in hoog tempo verandert, kunnen er dingen misgaan die we nu niet kunnen voorspellen.

Zijn bewijs: Claude schrijft nu zijn eigen opvolger

Waarom die korte tijdlijn? Amodei wijst op de exponentiële vooruitgang: drie jaar geleden kon AI amper één regel code schrijven, nu schrijven de sterkste ingenieurs bij Anthropic bijna al hun code met AI. Sterker nog: Claude helpt nu mee aan het bouwen van de volgende generatie Claude. Die feedbackloop versnelt met de maand.

Wat moeten we doen?

Amodei komt met een concrete lijst maatregelen:

Transparantiewetgeving – Verplicht AI-bedrijven om openheid te geven over risico’s en testresultaten van hun modellen.

Exportbeperkingen op chips – Houd geavanceerde chips weg bij autocratische regimes. Volgens Amodei de belangrijkste maatregel die we afzonderlijk kunnen nemen.

Constitutionele AI – Train modellen niet alleen met regels, maar met karakter en waarden. Anthropic publiceerde vorige week een 80 pagina’s tellende ‘grondwet’ voor Claude.

Interpretability-onderzoek – Ontwikkel technieken om te kunnen kijken wat er binnenin AI-modellen gebeurt, zodat je problemen kunt opsporen voordat ze zich manifesteren.

Guardrails tegen biorisico’s – Filters die voorkomen dat AI helpt bij het maken van biologische wapens. Anthropic betaalt hier naar eigen zeggen zo’n 5% van zijn computerkosten aan.

Progressieve belasting – Bij extreme vermogensconcentratie is herverdeling onvermijdelijk. Amodei waarschuwt miljardairs: “Als ze geen constructieve versie steunen, krijgen ze onvermijdelijk een destructieve versie, ontworpen door een boze menigte.”

Op dat laatste punt is Amodei opvallend direct: Elon Musk is nu al rijker dan Rockefeller op zijn piek was, als percentage van het BBP. En dat is nog vóór de echte economische impact van AI.

Context: Anthropic in de lift

Het essay komt op een moment dat Anthropic ongekend populair is. Volgens de Financial Times heeft het bedrijf zijn lopende investeringsronde verdubbeld van 10 naar 20 miljard dollar, vanwege de enorme vraag. De verwachte waardering: 350 miljard dollar.

Fortune merkt op dat het essay ook als marketingboodschap werkt: Anthropics nadruk op veiligheid onderscheidt het van concurrenten als OpenAI en xAI. Maar dat maakt de waarschuwingen niet minder relevant – en Amodei geeft zelf toe dat er veel onzekerheid is. AI hoeft niet zo snel te gaan als hij schetst, en de risico’s hoeven niet allemaal bewaarheid te worden.

Toch blijft zijn kernpunt overeind: de combinatie van snelheid, macht en onvoorspelbaarheid maakt dit een uniek moment. “De jaren voor ons worden onmogelijk zwaar,” schrijft hij. “Maar ik heb genoeg moed en edelmoedigheid gezien om te geloven dat we kunnen winnen.”

📅 Claude Code Masterclass deel 2 op 5 februari

Op 5 februari geeft Wietse de vervolgmasterclass over Skills & Subagents – hoe je Claude nog slimmer aan het werk zet en taken automatiseert.

De eerste masterclass – waarin we live een foodpairing-app, een roosterapplicatie en een iPhone-app bouwden – kun je nu hier terugkijken. Perfect voor dit weekend: kijken, zelf proberen, en op 5 februari live meedoen met deel twee.

Geen programmeerervaring nodig. Dat is juist het hele punt.

Juist mensgerichte inzet AI maakt Kindertelefoon-project betekenisvol

Met hulp van PwC keek De Kindertelefoon naar manieren om AI op een verantwoorde en veilige manier binnen de organisatie toe te passen. Lees hoe we samen tot een meerjarige routekaart kwamen.

🔮 Prompt whisperer

Hoe (on)beleefd moet je zijn tegen AI?

Je hebt ze vast weleens voorbij zien komen: virale tips op sociale media die beweren dat je ChatGPT moet uitschelden voor betere antwoorden. “Scheld je AI uit!” “Noem het een sukkel!” Het klinkt absurd, maar zulke posts krijgen soms duizenden likes en worden keer op keer gedeeld.

Tijd voor een MythBusters-editie. Klopt het dat onbeleefdheid werkt? En zo ja, waarom dan? We doken in het wetenschappelijk onderzoek en ontdekten dat de waarheid genuanceerder is dan de clickbait doet vermoeden.

Wat leer je vandaag?

Wat wetenschappelijk onderzoek zegt over beleefdheid en AI-prestaties.

Waarom de resultaten per model én per taal verschillen.

De échte reden waarom ‘onbeleefd’ soms beter werkt (spoiler: het gaat om iets anders).

Hoe je vriendelijk én effectief kunt prompten.

Praktische templates die je direct kunt toepassen.

Waarom OpenAI en Anthropic allebei hetzelfde advies geven.